前言

近期操作系统导论这门课程进入了实验阶段,ucoreOS实验共由9个部分构成,实验内容基本涵盖了构建一个简易操作系统的全部流程,具有很高的实用意义,故写下这篇文章以记录实验过程。如果你在实验过程中遇到了什么问题可以在下方留言讨论,同时敬请指正文章内容。

实验资料

Lab 0 操作系统实验准备

实验目的

- 了解操作系统开发实验环境

- 熟悉命令行方式的编译、调试工程

- 掌握基于硬件模拟器的调试技术

- 熟悉 C 语言编程和指针的概念

- 了解 X86 汇编语言

实验内容(操作部分)

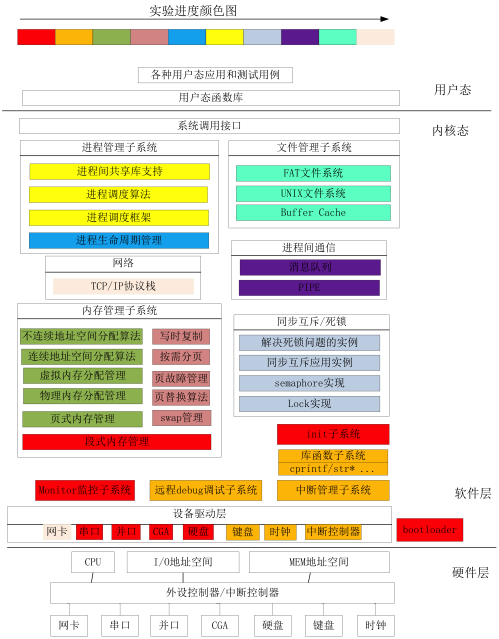

ucore 系统结构概览

设置实验环境

准备 Linux 系统

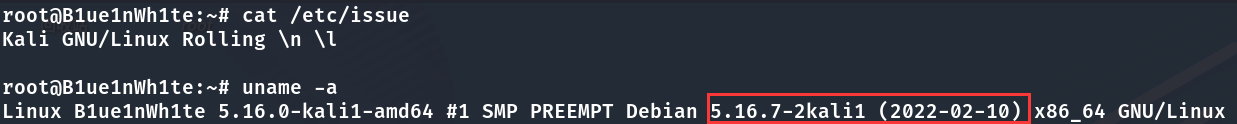

本实验是在Linux系统上进行的,推荐使用虚拟机安装运行,我使用的系统是安装在VMware Workstation Pro 16.0上的Kali Linux 2022.2 ,你可以使用其他系统,相信各位在前面的课程中已经安装好了Ubuntu 20.04系统,可以直接拿来用,如果想要安装其他的版本可以自行搜索相关教程。(本实验不推荐使用 WSL,之前我使用的是 WSL2 下的Ubuntu 20.04.4 LTS,但经常遇到一些莫名其妙的 BUG。虽然本实验中不适合用,但 WSL 本身是有一些优点的,如果你的系统已经升级为了Windows 11并且想要尝试在 WSL2 中安装 Linux,可以参考森大的这篇文章 Windows Subsystem for Linux 2 的艺术 进行操作。)

我实验时使用的系统如下图所示。

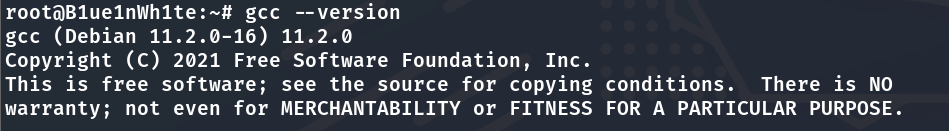

安装 GCC 编译环境

GCC 的重要性不言而喻,它一般是系统自带就有的,如果你不确定是否已经安装,可以运行以下命令来安装编译构建时必需的工具:

sudo apt-get update //更新软件包列表

sudo apt-get install build-essential //安装编译必需软件包输入gcc --version时能看到版本号则为安装正确。

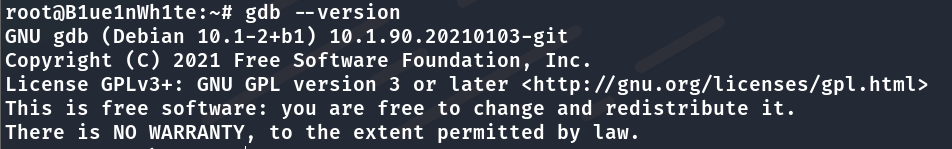

安装 GDB

运行以下命令安装 GDB 调试工具:

sudo apt-get install gdb输入gdb --version时能看到版本号则为安装正确。

安装 Git 工具

Git 工具用于操作和管理代码仓库,我们平时要从 Github 克隆仓库代码到本地时会经常用到,可以运行以下命令进行安装:

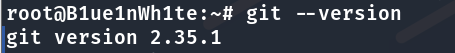

sudo apt-get install git输入git --version时能看到版本号则为安装正确。

克隆实验仓库

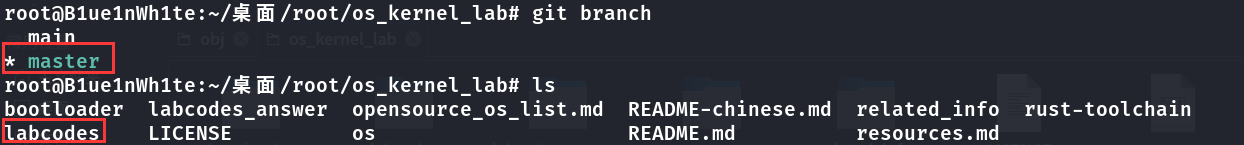

克隆时需要注意的一点是,我们的实验用的是ucore,而代码仓库的main分支上的是rcore,我们克隆下来后还需要切换为master分支才行。具体命令如下:

git clone https://github.com/chyyuu/os_kernel_lab.git //克隆实验仓库

cd os_kernel_lab //切换至仓库目录

git checkout origin/master //切换至master分支

git checkout -b master //基于远程master分支在本地建立master分支由于不科学的原因,我们克隆的时候可能会异常地慢,但可惜之前很多能用的镜像加速都被封了,且在 Linux 上配置科学上网有一定难度,所以综合下来考虑,还是搁这硬等它下载好比较妥当,一共 90M 左右其实还好。

如图所示即为操作正确,分支必须为master,仓库目录下必须有labcodes文件夹。

安装硬件模拟器 QEMU

QEMU 是优秀且知名的一款硬件模拟器工具,对于我们的实验而言,它可用于模拟一台 X86 计算机,让ucore能够在其上运行。

使用下面的命令安装 QEMU:

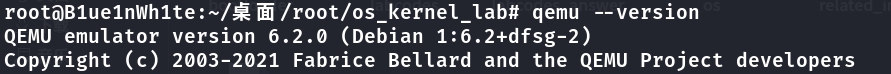

sudo apt-get install qemu qemu-system-i386 //安装qemu的i386模拟器

// 如果安装完后直接输入qemu没有反应,则运行以下指令

sudo ln -s /usr/bin/qemu-system-i386 /usr/bin/qemu //建立x86模拟器的软链接当输入命令qemu --version能看到版本号时则代表安装成功。

使用硬件模拟器 QEMU

qemu 运行可以有多参数,格式如:

qemu [options] [disk_image]其中 disk_image 即硬盘镜像文件。

部分参数说明:

`-hda file' `-hdb file' `-hdc file' `-hdd file'

使用 file 作为硬盘0、1、2、3镜像。

`-fda file' `-fdb file'

使用 file 作为软盘镜像,可以使用 /dev/fd0 作为 file 来使用主机软盘。

`-cdrom file'

使用 file 作为光盘镜像,可以使用 /dev/cdrom 作为 file 来使用主机 cd-rom。

`-boot [a|c|d]'

从软盘(a)、光盘(c)、硬盘启动(d),默认硬盘启动。

`-snapshot'

写入临时文件而不写回磁盘镜像,可以使用 C-a s 来强制写回。

`-m megs'

设置虚拟内存为 msg M字节,默认为 128M 字节。

`-smp n'

设置为有 n 个 CPU 的 SMP 系统。以 PC 为目标机,最多支持 255 个 CPU。

`-nographic'

禁止使用图形输出。

其他:

可用的主机设备 dev 例如:

vc

虚拟终端。

null

空设备

/dev/XXX

使用主机的 tty。

file: filename

将输出写入到文件 filename 中。

stdio

标准输入/输出。

pipe:pipename

命令管道 pipename。

等。

使用 dev 设备的命令如:

`-serial dev'

重定向虚拟串口到主机设备 dev 中。

`-parallel dev'

重定向虚拟并口到主机设备 dev 中。

`-monitor dev'

重定向 monitor 到主机设备 dev 中。

其他参数:

`-s'

等待 gdb 连接到端口 1234。

`-p port'

改变 gdb 连接端口到 port。

`-S'

在启动时不启动 CPU, 需要在 monitor 中输入 'c',才能让qemu继续模拟工作。

`-d'

输出日志到 qemu.log 文件。(此处仅是举例)例如:

qemu -hda ucore.img -parallel stdio // 让ucore在qemu模拟的x86硬件环境中运行qemu -S -s -hda ucore.img -monitor stdio // 开启远程调试使用 GDB 配合 QEMU 对 ucore 进行源码级调试

ucore 代码编译

在实验文件夹下使用make命令即可,make 会按照当前目录下的Makefile脚本构建项目。

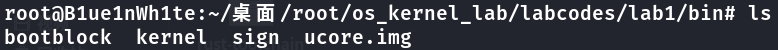

例如在 Lab1 中:

cd ./os_kernel_lab/labcodes/lab1

make此时在 lab1 目录下的 bin 目录中会生成一系列的目标文件:

- ucore.img:系统镜像文件

- kernel: ELF 格式的系统内核文件,被嵌入到了ucore.img中

- bootblock: 虚拟的硬盘主引导扇区(512 字节),包含了 bootloader 执行代码,被嵌入到了ucore.img中

- sign:小工具,用来生成符合规范的虚拟硬盘主引导扇区

还生成了很多其他文件,后续的实验会慢慢接触到。

使用远程调试

为了与 qemu 配合进行源代码级别的调试,需要先让 qemu 等待 gdb 调试器的接入并且不能让 qemu 中的 CPU 在此之前执行,因此启动 qemu 的时候,我们需要使用参数-S –s来做到这一点,这相当于在本地的1234端口开启远程调试服务。

在使用了前面提到的参数启动 qemu 之后,qemu 中的 CPU 并不会马上开始执行,这时我们启动 gdb,然后在 gdb 命令行界面下,使用下面的命令连接到 qemu:

//此时在lab1目录下

(gdb) target remote :1234然后输入 c(也就是 continue)命令之后,qemu 会继续执行下去,但是 gdb 由于不知道任何符号信息,并且也没有下断点,是不能进行源码级的调试的。为了让 gdb 获知符号信息,需要指定调试目标文件,gdb 中使用 file 命令:

(gdb) file ./bin/kernel之后 gdb 就会载入这个文件中的符号信息了。

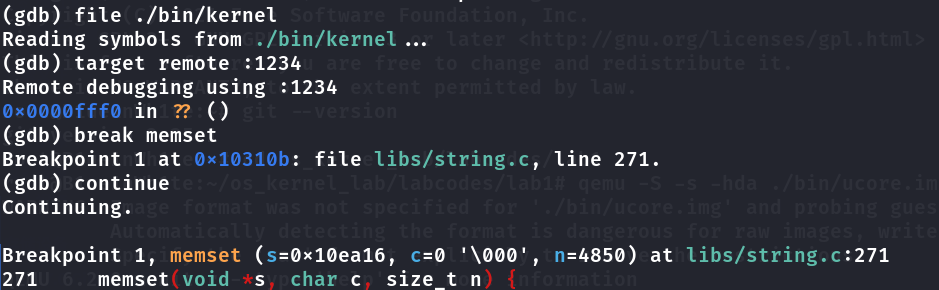

这时通过 gdb 就可以对 ucore 代码进行调试了,以在lab1中调试memset函数为例:

在第一个终端中执行:

//此时在lab1目录下

qemu -S -s -hda ./bin/ucore.img -monitor stdio // 启动qemu运行ucore并开启远程调试服务这时会弹出一个窗口,qemu 已经开始等待远程 gdb 的连接了,接下来打开第二个终端运行 gdb。(如果你在此过程中发现鼠标指针不见了,这是因为你点击到了 qemu 的图形窗口导致鼠标被其捕获,使用快捷键Ctrl+Alt+G即可重新获取鼠标控制权。)

在第二个终端中执行:

cd os_kernel_lab/labcodes/lab1 //切换至lab1的目录

gdb //启动gdb

(gdb) file ./bin/kernel //在gdb中载入目标文件以获取符号信息

(gdb) target remote :1234 //用gdb连接至本地的1234端口进行调试

(gdb) break memset //在memset函数处下断点

(gdb) continue //调试至断点

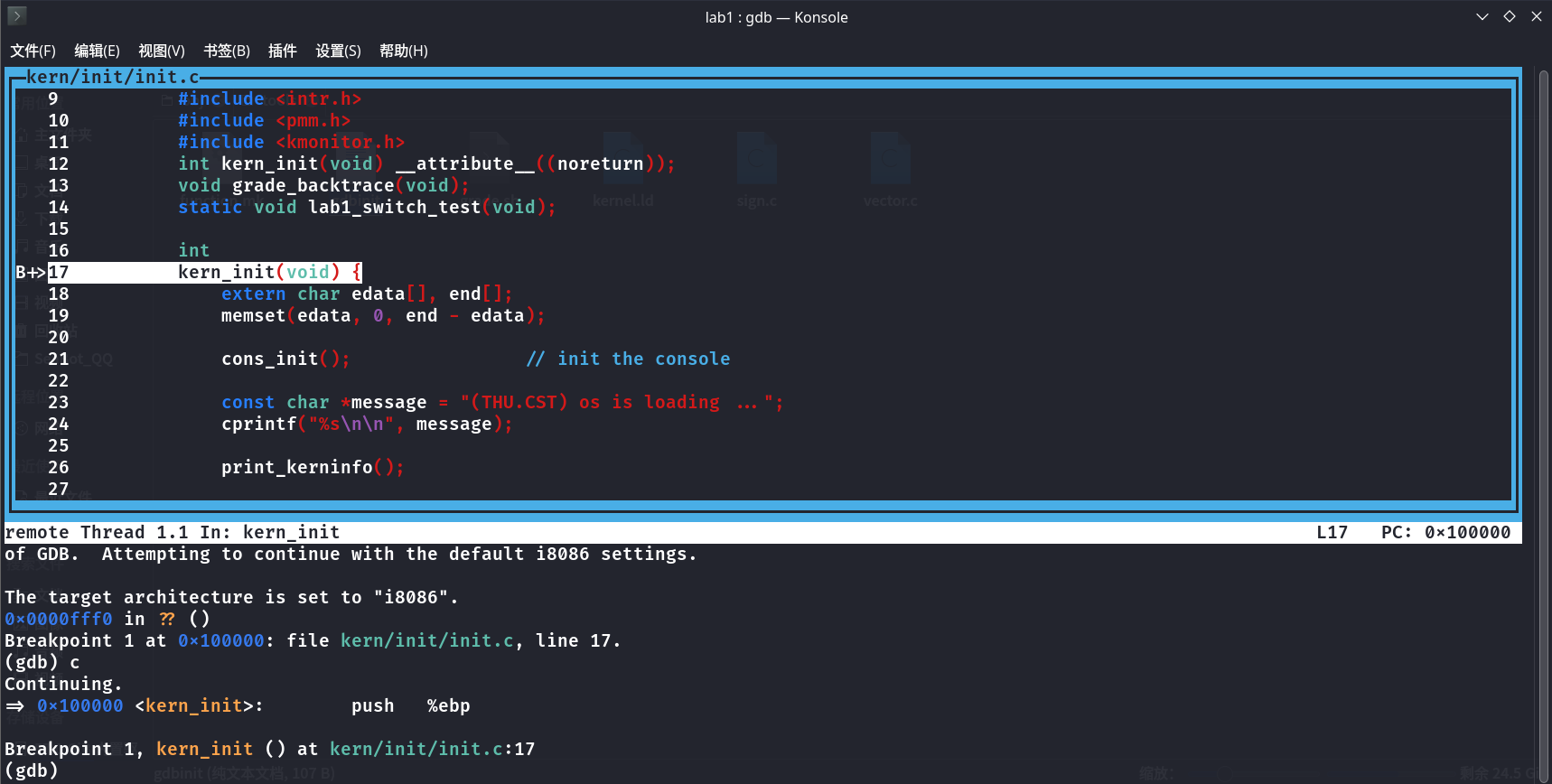

使用 GDB 配置文件

从上面可以看到,为了进行源码级调试,需要输入很多指令。为了方便,可以将这些命令保存在脚本中,并让 gdb 在启动的时候载入。

以 lab1 为例,在lab1/tools目录下,执行完make后,我们可以修改gdbinit文件。

cd ./tools //切换至tools目录

vim gdbinit //使用vim修改gdbinit的文件内容,如果提示未安装则使用sudo apt-get install vim进行安装

//此时会进入文本编辑窗口,如下编辑文件内容(第5-10行),注释不用复制

file bin/kernel //在gdb中载入目标文件以获取符号信息

set architecture i8086 //设置CPU架构为i8086

target remote :1234 //用gdb连接至本地的1234端口进行调试

break kern_init //在内核初始化函数处设置断点

define hook-stop //这部分设置每次单步调试都显示出附近两行的汇编以方便调试

x/2i $pc

end

//然后按下ESC键退出编辑模式,最后输入:wq后按ENTER键保存修改并退出。使用上面编辑好的脚本启动 gdb:

cd .. //退回lab1目录

gdb -tui -x tools/gdbinit //以gdbinit脚本启动gdb并开启源代码视图

其他

后续会用到的一些指令:

make grade // 测试编写的实验代码是否基本正确

make handin // 如果实现基本正确(即看到上条指令输出都是OK)则生成实验打包

make qemu // 让OS实验工程在qemu上运行

make debug // 实现通过gdb远程调试OS实验工程diff用于比较文本或者文件夹差异。patch可以对文件或者文件夹应用修改。

例如实验中可能会在proj_b中应用前一个实验proj_a中对文件的修改,可以使用如下命令:

diff -r -u -P proj_a_original proj_a_mine > diff.patch

cd proj_b

patch -p1 -u < ../diff.patch注意:proj_a_original指 proj_a 的源文件,即未经修改的源码包,proj_a_mine是修改后的代码包。第一条命令是递归的比较文件夹差异,并将结果重定向输出到diff.patch文件中,第三条命令是将proj_a的修改应用到 proj_b 文件夹中的代码中。

设定调试目标架构:

在调试的时候,我们也许需要调试非 i386 保护模式的代码,而是比如 8086 实模式的代码,这时我们需要设定当前使用的架构:

(gdb) set architecture i8086这个方法在调试不同架构或者说不同模式的代码时还是有用处的。

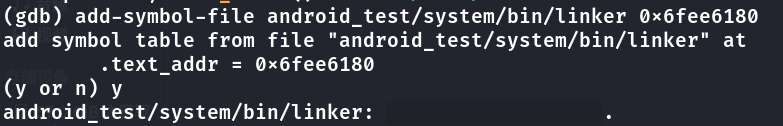

加载调试目标:

在上面小节,我们提到为了能够让 gdb 识别变量的符号,我们必须给 gdb 载入符号表等信息。在进行 gdb 本地应用程序调试的时候,因为在指定了执行文件时就已经加载了文件中包含的调试信息,因此不用再使用 gdb 命令专门加载了。但是在使用 qemu 进行远程调试的时候,我们必须手动加载符号表,也就是在 gdb 中用 file 命令。

这样加载调试信息都是按照 elf 文件中制定的虚拟地址进行加载的,这在静态连接的代码中没有任何问题。但是在调试含有动态链接库的代码时,动态链接库的 ELF 执行文件头中指定的加载虚拟地址都是 0,这个地址实际上是不正确的。从操作系统角度来看,用户态的动态链接库的加载地址都是由操作系统动态分配的,没有一个固定值。然后操作系统再把动态链接库加载到这个地址,并由用户态的库链接器(linker)把动态链接库中的地址信息重新设置,自此动态链接库才可正常运行。

由于分配地址的动态性,gdb 并不知道这个分配的地址是多少,因此当我们在对这样动态链接的代码进行调试的时候,需要手动要求 gdb 将调试信息加载到指定地址。下面,我们要求 gdb 将 linker 加载到 0x6fee6180 这个地址上:

(gdb) add-symbol-file android_test/system/bin/linker 0x6fee6180

这个方法在操作系统中调试动态链接器时特别有用。

实验内容(理论部分)

编译可调试的目标文件

为了使得编译出来的代码能够被 gdb 这样的调试器调试,我们需要在使用 gcc 编译源文件的时候添加参数:-g,这样编译出来的目标文件中才会包含可以用于调试器进行调试的相关符号信息。

AT&T 汇编基本语法

这部分内容我们在计算机系统课程已经学习掌握了,在此直接略过,如果还想复习一下可以 查看实验指导书上的内容 。

make 和 Makefile

GNU make(简称 make)是一种代码维护工具,在大中型项目中,它将根据程序各个模块的更新情况,自动的维护和生成目标代码。

make 命令执行时,需要一个 makefile (或 Makefile)文件,以告诉 make 命令需要怎么样的去编译和链接程序。首先,我们用一个示例来说明 makefile 的书写规则。以便给大家一个感性认识。这个示例来源于 gnu 的 make 使用手册,在这个示例中,我们的工程有 8 个 c 文件,和 3 个头文件,我们要写一个 makefile 来告诉 make 命令如何编译和链接这几个文件。我们的规则是:

- 如果这个工程没有编译过,那么我们的所有 c 文件都要编译并被链接。

- 如果这个工程的某几个 c 文件被修改,那么我们只编译被修改的 c 文件,并链接目标程序。

- 如果这个工程的头文件被改变了,那么我们需要编译引用了这几个头文件的 c 文件,并链接目标程序。

只要我们的 makefile 写得够好,所有的这一切,我们只用一个 make 命令就可以完成,make 命令会自动智能地根据当前的文件修改的情况来确定哪些文件需要重编译,从而自己编译所需要的文件和链接目标程序。

makefile 的规则:

target ... : prerequisites ...

command

...

...target 也就是一个目标文件,可以是 object file,也可以是执行文件。还可以是一个标签(label)。prerequisites 就是,要生成那个 target 所需要的文件或是目标。command 也就是 make 需要执行的命令(任意的 shell 命令)。 这是一个文件的依赖关系,也就是说,target 这一个或多个的目标文件依赖于 prerequisites 中的文件,其生成规则定义在 command 中。如果 prerequisites 中有一个以上的文件比 target 文件要新,那么 command 所定义的命令就会被执行。这就是 makefile 的规则。也就是 makefile 中最核心的内容。

GDB 使用

这部分内容我们在计算机系统课程已经学习掌握了,在此直接略过,如果还想复习一下可以 查看实验指导书上的内容 ,也可以看看肖神的文章 gdb 常用命令。

GCC 基本内联汇编

GCC 提供了两类内联汇编语句:基本内联汇编语句和扩展内联汇编语句。GCC 基本内联汇编很简单,一般是按照下面的格式:

asm("statements");例如:

asm("nop"); asm("cli");asm 和 __asm__ 的含义是完全一样的。如果有多行汇编,则每一行都要加上\n\t。其中的 \n 是换行符,\t 是 tab 符,在每条指令的末尾加上这两个符号,是为了让 GCC 把内联汇编代码翻译成一般的汇编代码时能够保证换行和留有一定的空格。对于基本 asm 语句,GCC 编译出来的汇编代码就是双引号里的内容。例如:

asm( "pushl %eax\n\t"

"movl $0,%eax\n\t"

"popl %eax"

);实际上 GCC 在处理汇编时,是要把 asm(...)的内容"打印"到汇编文件中,所以格式控制字符是必要的。再例如:

asm("movl %eax, %ebx");

asm("xorl %ebx, %edx");

asm("movl $0, _boo);在上面的例子中,由于我们在内联汇编中改变了 edx 和 ebx 的值,但是由于 GCC 的特殊的处理方法,即先形成汇编文件,再交给 GAS 去汇编,所以 GAS 并不知道我们已经改变了 edx 和 ebx 的值,如果程序的上下文需要 edx 或 ebx 作其他内存单元或变量的暂存,就会产生预料之外的多次赋值,引起严重的后果。对于变量 \_boo 也存在一样的问题。为了解决这个问题,就要用到扩展 GCC 内联汇编语法。

参考:

- GCC Manual, 版本为 5.0.0 pre-release,6.43 节(How to Use Inline Assembly Language in C Code)

- GCC-Inline-Assembly-HOWTO

GCC 扩展内联汇编

使用 GCC 扩展内联汇编的例子如下:

#define read_cr0() ({ \

unsigned int __dummy; \

__asm__( \

"movl %%cr0,%0\n\t" \

:"=r" (__dummy)); \

__dummy; \

})它代表什么含义呢?这需要从其基本格式讲起。GCC 扩展内联汇编的基本格式是:

asm [volatile] ( Assembler Template

: Output Operands

[ : Input Operands

[ : Clobbers ] ])其中,__asm__ 表示汇编代码的开始,其后可以跟 __volatile__(这是可选项),其含义是避免 "asm" 指令被删除、移动或组合,在执行代码时,如果不希望汇编语句被 GCC 优化而改变位置,就需要在 asm 符号后添加 volatile 关键词:asm volatile(...);或者更详细地说明为:__asm__ __volatile__(...);然后就是小括弧,括弧中的内容是具体的内联汇编指令代码。 "" 为汇编指令部分,例如,"movl %%cr0,%0\n\t"。数字前加前缀 "%",如%1,%2 等表示使用寄存器的样板操作数。可以使用的操作数总数取决于具体 CPU 中通用寄存器的数量,如 Intel 可以有 8 个。指令中有几个操作数,就说明有几个变量需要与寄存器结合,由 GCC 在编译时根据后面输出部分和输入部分的约束条件进行相应的处理。由于这些样板操作数的前缀使用了"%",因此,在用到具体的寄存器时就在前面加两个%,如%%cr0。

输出部分(output operand list),用以规定对输出变量(目标操作数)如何与寄存器结合的约束(constraint),输出部分可以有多个约束,互相以逗号分开。每个约束以“=”开头,接着用一个字母来表示操作数的类型,然后是关于变量结合的约束。例如,上例中:

:"=r" (__dummy)“= r”表示相应的目标操作数(指令部分的%0)可以使用任何一个通用寄存器,并且变量\_\_dummy 存放在这个寄存器中,但如果是:

:"=m"(__dummy)"= m"就表示相应的目标操作数是存放在内存单元\_\_dummy 中。表示约束条件的字母很多,下表给出几个主要的约束字母及其含义:

| 字母 | 含义 |

|---|---|

| m, v, o | 内存单元 |

| R | 任何通用寄存器 |

| Q | 寄存器 eax, ebx, ecx,edx 之一 |

| I, h | 直接操作数 |

| E, F | 浮点数 |

| G | 任意 |

| a, b, c, d | 寄存器 eax/ax/al, ebx/bx/bl, ecx/cx/cl 或 edx/dx/dl |

| S, D | 寄存器 esi 或 edi |

| I | 常数(0 ~ 31) |

输入部分(input operand list):输入部分与输出部分相似,但没有"="。如果输入部分一个操作数所要求使用的寄存器,与前面输出部分某个约束所要求的是同一个寄存器,那就把对应操作数的编号(如"1","2"等)放在约束条件中。在后面的例子中,可看到这种情况。

修改部分(clobber list,也称 乱码列表):这部分常常以"memory"为约束条件,以表示操作完成后内存中的内容已有改变,如果原来某个寄存器的内容来自内存,那么现在内存中这个单元的内容已经改变。乱码列表通知编译器,有些寄存器或内存因内联汇编块造成乱码,可隐式地破坏了条件寄存器的某些位(字段)。 注意,指令部分为必选项,而输入部分、输出部分及修改部分为可选项,当输入部分存在,而输出部分不存在时,冒号":"要保留,当"memory"存在时,三个冒号都要保留,例如:

#define __cli() __asm__ __volatile__("cli": : :"memory")下面是一个例子:

int count=1;

int value=1;

int buf[10];

void main()

{

asm(

"cld \n\t"

"rep \n\t"

"stosl"

:

: "c" (count), "a" (value) , "D" (buf)

);

}得到的主要汇编代码为:

movl count,%ecx

movl value,%eax

movl buf,%edi

#APP

cld

rep

stosl

#NO_APPcld,rep,stos 这几条语句的功能是向 buf 中写上 count 个 value 值。冒号后的语句指明输入,输出和被改变的寄存器。通过冒号以后的语句,编译器就知道你的指令需要和改变哪些寄存器,从而可以优化寄存器的分配。其中符号"c"(count)指示要把 count 的值放入 ecx 寄存器。类似的还有:

a eax

b ebx

c ecx

d edx

S esi

D edi

I 常数值,(0 - 31)

q,r 动态分配的寄存器

g eax,ebx,ecx,edx或内存变量

A 把eax和edx合成一个64位的寄存器(use long longs)也可以让 gcc 自己选择合适的寄存器。如下面的例子:

asm("leal (%1,%1,4),%0"

: "=r" (x)

: "0" (x)

);这段代码的主要汇编代码为:

movl x,%eax

#APP

leal (%eax,%eax,4),%eax

#NO_APP

movl %eax,x几点说明:

- [1] 使用 q 指示编译器从 eax, ebx, ecx, edx 分配寄存器。 使用 r 指示编译器从 eax, ebx, ecx, edx, esi, edi 分配寄存器。

- [2] 不必把编译器分配的寄存器放入改变的寄存器列表,因为寄存器已经记住了它们。

- [3] "="是标示输出寄存器,必须这样用。

- [4] 数字%n 的用法:数字表示的寄存器是按照出现和从左到右的顺序映射到用"r"或"q"请求的寄存器.如果要重用"r"或"q"请求的寄存器的话,就可以使用它们。

- [5] 如果强制使用固定的寄存器的话,如不用%1,而用 ebx,则:

asm("leal (%%ebx,%%ebx,4),%0"

: "=r" (x)

: "0" (x)

);注意要使用两个%,因为一个%的语法已经被%n 用掉了。

参考:

- GCC Manual, 版本为 5.0.0 pre-release,6.43 节(How to Use Inline Assembly Language in C Code)

- GCC-Inline-Assembly-HOWTO

了解处理器硬件

要想深入理解 ucore,就需要了解支撑 ucore 运行的硬件环境,即了解处理器体系结构(了解硬件对 ucore 带来影响)和机器指令集(读懂 ucore 的汇编)。ucore 目前支持的硬件环境是基于 Intel 80386 以上的计算机系统。更多的硬件相关内容(比如保护模式等)将随着实现 ucore 的过程逐渐展开介绍。

Intel 80386 运行模式

点击打开实验指导书浏览相关内容。

Intel 80386 内存架构

点击打开实验指导书浏览相关内容。

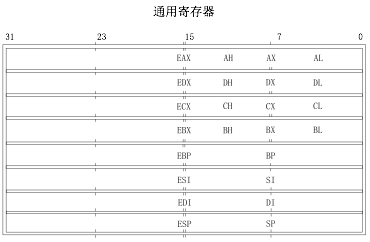

Intel 80386 寄存器

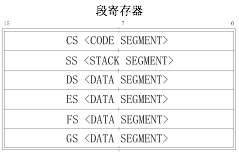

80386 的寄存器可以分为 8 组:通用寄存器,段寄存器,指令指针寄存器,标志寄存器,系统地址寄存器,控制寄存器,调试寄存器,测试寄存器,它们的宽度都是 32 位。一般程序员看到的寄存器包括通用寄存器,段寄存器,指令指针寄存器,标志寄存器。

General Register(通用寄存器):EAX/EBX/ECX/EDX/ESI/EDI/ESP/EBP 这些寄存器的低 16 位就是 8086 的 AX/BX/CX/DX/SI/DI/SP/BP,对于 AX,BX,CX,DX 这四个寄存器来讲,可以单独存取它们的高 8 位和低 8 位 (AH/AL/BH/BL/CH/CL/DH/DL)。它们的含义如下:

- EAX:累加器

- EBX:基址寄存器

- ECX:计数器

- EDX:数据寄存器

- ESI:源地址指针寄存器

- EDI:目的地址指针寄存器

- EBP:基址指针寄存器

- ESP:堆栈指针寄存器

Segment Register(段寄存器,也称Segment Selector,段选择符,段选择子):除了 8086 的 4 个段外(CS/DS/ES/SS),80386 还增加了两个段FS/GS,这些段寄存器都是 16 位的,用于不同属性内存段的寻址,它们的含义如下:

- CS:代码段(Code Segment)

- DS:数据段(Data Segment)

- ES:附加数据段(Extra Segment)

- SS:堆栈段(Stack Segment)

- FS:附加段

- GS:附加段

Instruction Pointer(指令指针寄存器):EIP 的低 16 位就是 8086 的 IP,它存储的是下一条要执行指令的内存地址,在分段地址转换中,表示指令的段内偏移地址。

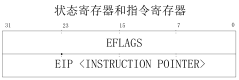

Flag Register(标志寄存器):EFLAGS,和 8086 的 16 位标志寄存器相比,增加了 4 个控制位,这 20 位控制/标志位的位置如下图所示:

相关的控制/标志位含义是:

- CF(Carry Flag):进位标志位

- PF(Parity Flag):奇偶标志位

- AF(Assistant Flag):辅助进位标志位

- ZF(Zero Flag):零标志位

- SF(Singal Flag):符号标志位

- IF(Interrupt Flag):中断允许标志位,由 CLI,STI 两条指令来控制;设置 IF 位使 CPU 可识别外部(可屏蔽)中断请求,复位 IF 位则禁止中断,IF 位对不可屏蔽外部中断和故障中断的识别没有任何作用

- DF(Direction Flag):向量标志位,由 CLD,STD 两条指令来控制

- OF(Overflow Flag):溢出标志位

- IOPL(I/O Privilege Level):I/O 特权级字段,它的宽度为 2 位,它指定了 I/O 指令的特权级。如果当前的特权级别在数值上小于或等于 IOPL,那么 I/O 指令可执行。否则,将发生一个保护性故障中断

- NT(Nested Task):控制中断返回指令 IRET,它宽度为 1 位。若 NT=0,则用堆栈中保存的值恢复 EFLAGS,CS 和 EIP 从而实现中断返回;若 NT=1,则通过任务切换实现中断返回。在 ucore 中,设置 NT 为 0。

还有一些应用程序无法访问的控制寄存器,如 CR0,CR2,CR3...

了解 ucore 编程方法和通用数据结构

面向对象编程方法

点击打开实验指导书浏览相关内容。

通用数据结构-双向循环链表

点击打开实验指导书浏览相关内容。

Lab 1 系统软件启动过程

实验目的

操作系统是一个软件,也需要通过某种机制加载并运行它。在这里我们将通过另外一个更加简单的软件:bootloader来完成这些工作。为此,我们需要完成一个能够切换到 x86 的保护模式并显示字符的 bootloader,为启动操作系统 ucore 做准备。

lab1 提供了一个非常小的 bootloader 和 ucore OS,整个 bootloader 执行代码小于 512 个字节,这样才能放到硬盘的主引导扇区中。通过分析和实现这个 bootloader 和 ucore OS,读者可以了解到:

- 计算机原理

- CPU 的编址与寻址: 基于分段机制的内存管理

- CPU 的中断机制

- 外设:串口/并口/CGA(Color Graphics Adapter) 彩色图形适配器,时钟,硬盘

- bootloader 软件

- 编译运行 bootloader 的过程

- 调试 bootloader 的方法

- PC 启动 bootloader 的过程

- ELF 执行文件的格式和加载

- 外设访问:读硬盘,在 CGA 上显示字符串

- ucore OS 软件

- 编译运行 ucore OS 的过程

- ucore OS 的启动过程

- 调试 ucore OS 的方法

- 函数调用关系:在汇编级了解函数调用栈的结构和处理过程

- 中断管理:与软件相关的中断处理

- 外设管理:时钟

实验内容(操作部分)

lab1 中包含一个 bootloader 和一个 OS。这个 bootloader 可以切换到 X86 保护模式,能够读磁盘并加载 ELF 执行文件格式,并显示字符。

实验报告要求

点击打开实验指导书浏览实验报告要求。

练习总体要求:列出本实验各练习中对应的 OS 原理的知识点,并说明本实验中的实现部分如何对应和体现了原理中的基本概念和关键知识点。

如果你需要编写Markdown格式的实验报告,推荐下载Typora。

项目组成

lab1 的整体目录结构如下所示:

.

├── boot

│ ├── asm.h

│ ├── bootasm.S

│ └── bootmain.c

├── kern

│ ├── debug

│ │ ├── assert.h

│ │ ├── kdebug.c

│ │ ├── kdebug.h

│ │ ├── kmonitor.c

│ │ ├── kmonitor.h

│ │ ├── panic.c

│ │ └── stab.h

│ ├── driver

│ │ ├── clock.c

│ │ ├── clock.h

│ │ ├── console.c

│ │ ├── console.h

│ │ ├── intr.c

│ │ ├── intr.h

│ │ ├── kbdreg.h

│ │ ├── picirq.c

│ │ └── picirq.h

│ ├── init

│ │ └── init.c

│ ├── libs

│ │ ├── readline.c

│ │ └── stdio.c

│ ├── mm

│ │ ├── memlayout.h

│ │ ├── mmu.h

│ │ ├── pmm.c

│ │ └── pmm.h

│ └── trap

│ ├── trap.c

│ ├── trapentry.S

│ ├── trap.h

│ └── vectors.S

├── libs

│ ├── defs.h

│ ├── elf.h

│ ├── error.h

│ ├── printfmt.c

│ ├── stdarg.h

│ ├── stdio.h

│ ├── string.c

│ ├── string.h

│ └── x86.h

├── Makefile

└── tools

├── function.mk

├── gdbinit

├── grade.sh

├── kernel.ld

├── sign.c

└── vector.c

10 directories, 48 filesbootloader 部分

boot/bootasm.S:定义并实现了 bootloader 最先执行的函数 start,此函数进行了一定的初始化,完成了从实模式到保护模式的转换,并调用 bootmain.c 中的 bootmain 函数。boot/bootmain.c:定义并实现了 bootmain 函数实现了通过屏幕、串口和并口显示字符串。bootmain 函数加载 ucore 操作系统到内存,然后跳转到 ucore 的入口处执行。boot/asm.h:是 bootasm.S 汇编文件所需要的头文件,主要是一些与 X86 保护模式的段访问方式相关的宏定义。

ucore 操作系统部分

系统初始化部分:

kern/init/init.c:ucore 操作系统的初始化启动代码

内存管理部分:

kern/mm/memlayout.h:ucore 操作系统有关段管理(段描述符编号、段号等)的一些宏定义kern/mm/mmu.h:ucore 操作系统有关 X86 MMU 等硬件相关的定义,包括 EFLAGS 寄存器中各位的含义,应用/系统段类型,中断门描述符定义,段描述符定义,任务状态段定义,NULL 段声明的宏 SEG_NULL, 特定段声明的宏 SEG,设置中断门描述符的宏 SETGATEkern/mm/pmm.[ch]:设定了 ucore 操作系统在段机制中要用到的全局变量:任务状态段 ts,全局描述符表 gdt[],加载全局描述符表寄存器的函数 lgdt,临时的内核栈 stack0;以及对全局描述符表和任务状态段的初始化函数 gdt_init

外设驱动部分:

kern/driver/intr.[ch]:实现了通过设置 CPU 的 eflags 来屏蔽和使能中断的函数kern/driver/picirq.[ch]:实现了对中断控制器 8259A 的初始化和使能操作kern/driver/clock.[ch]:实现了对时钟控制器 8253 的初始化操作kern/driver/console.[ch]:实现了对串口和键盘的中断方式的处理操作

中断处理部分:

kern/trap/vectors.S:包括 256 个中断服务例程的入口地址和第一步初步处理实现。注意,此文件是由 tools/vector.c 在编译 ucore 期间动态生成的kern/trap/trapentry.S:紧接着第一步初步处理后,进一步完成第二步初步处理;并且有恢复中断上下文的处理,即中断处理完毕后的返回准备工作kern/trap/trap.[ch]:紧接着第二步初步处理后,继续完成具体的各种中断处理操作

内核调试部分:

kern/debug/kdebug.[ch]:提供源码和二进制对应关系的查询功能,用于显示调用栈关系。其中补全 print_stackframe 函数是需要完成的练习。其他实现部分不必深究。kern/debug/kmonitor.[ch]:实现提供动态分析命令的 kernel monitor,便于在 ucore 出现 bug 或问题后,能够进入 kernel monitor 中,查看当前调用关系。实现部分不必深究。kern/debug/panic.c | assert.h:提供了 panic 函数和 assert 宏,便于在发现错误后,调用 kernel monitor。大家可在编程实验中充分利用 assert 宏和 panic 函数,提高查找错误的效率。

公共库部分

libs/defs.h:包含一些无符号整型的缩写定义。libs/x86.h:一些用 GNU C 嵌入式汇编实现的 C 函数(由于使用了 inline 关键字,所以可以理解为宏)。

工具部分

Makefile和function.mk:指导 make 完成整个软件项目的编译,清除等工作。sign.c:一个 C 语言小程序,是辅助工具,用于生成一个符合规范的硬盘主引导扇区。tools/vector.c:生成 vectors.S,此文件包含了中断向量处理的统一实现。

编译方法

在 lab1 目录下执行make,可以生成ucore.img(生成于 bin 目录下)。ucore.img是一个包含了 bootloader 或 OS 的硬盘镜像,通过执行如下命令可在硬件虚拟环境 qemu中运行 bootloader 或 OS:

make qemu则可以得到如下显示界面(仅供参考)

(THU.CST) os is loading ...

Special kernel symbols:

entry 0x00100000 (phys)

etext 0x00103468 (phys)

edata 0x0010ea18 (phys)

end 0x0010fd80 (phys)

Kernel executable memory footprint: 64KB

ebp:0x00007b38 eip:0x00100a55 args:0x00010094 0x00010094 0x00007b68 0x00100084

kern/debug/kdebug.c:305: print_stackframe+21

ebp:0x00007b48 eip:0x00100d3a args:0x00000000 0x00000000 0x00000000 0x00007bb8

kern/debug/kmonitor.c:125: mon_backtrace+10

ebp:0x00007b68 eip:0x00100084 args:0x00000000 0x00007b90 0xffff0000 0x00007b94

kern/init/init.c:48: grade_backtrace2+19

ebp:0x00007b88 eip:0x001000a5 args:0x00000000 0xffff0000 0x00007bb4 0x00000029

kern/init/init.c:53: grade_backtrace1+27

ebp:0x00007ba8 eip:0x001000c1 args:0x00000000 0x00100000 0xffff0000 0x00100043

kern/init/init.c:58: grade_backtrace0+19

ebp:0x00007bc8 eip:0x001000e1 args:0x00000000 0x00000000 0x00000000 0x00103480

kern/init/init.c:63: grade_backtrace+26

ebp:0x00007be8 eip:0x00100050 args:0x00000000 0x00000000 0x00000000 0x00007c4f

kern/init/init.c:28: kern_init+79

ebp:0x00007bf8 eip:0x00007d61 args:0xc031fcfa 0xc08ed88e 0x64e4d08e 0xfa7502a8

<unknow>: -- 0x00007d60 --

++ setup timer interrupts

0: @ring 0

0: cs = 8

0: ds = 10

0: es = 10

0: ss = 10

+++ switch to user mode +++

1: @ring 3

1: cs = 1b

1: ds = 23

1: es = 23

1: ss = 23

+++ switch to kernel mode +++

2: @ring 0

2: cs = 8

2: ds = 10

2: es = 10

2: ss = 10

100 ticks

100 ticks

100 ticks

100 ticks练习 1:理解通过 make 生成执行文件的过程

本练习任务是 通过静态分析代码来了解:

- 操作系统镜像文件

ucore.img是如何一步步生成的?(需要比较详细地解释 Makefile 中每一条相关命令和命令参数的含义,以及说明命令导致的结果) - 一个被系统认为是

符合规范的硬盘主引导扇区的特征是什么?

补充材料:

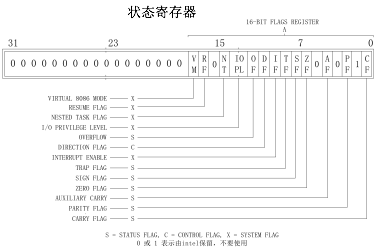

当执行make时,一般只会显示普通输出,不会显示 make 到底执行了哪些命令。

如想了解 make 执行了哪些命令,可以执行:

make clean //有时可能要先清除之前生成过的文件

make "V="下图是执行结果,可以看到很多细节信息被展示了出来。

要获取更多有关make命令的信息,可以执行:

man make也可上网查找相关资料,这里推荐一个工具网站 Linux 命令查询 。

问题一解答

题目:操作系统镜像文件 ucore.img 是如何一步步生成的?(需要比较详细地解释 Makefile 中每一条相关命令和命令参数的含义,以及说明命令导致的结果)

以下是Lab 1中Makefile的代码:

PROJ := challenge

EMPTY :=

SPACE := $(EMPTY) $(EMPTY)

SLASH := /

V := @

#need llvm/cang-3.5+

#USELLVM := 1

# try to infer the correct GCCPREFX

ifndef GCCPREFIX

GCCPREFIX := $(shell if i386-elf-objdump -i 2>&1 | grep '^elf32-i386$$' >/dev/null 2>&1; \

then echo 'i386-elf-'; \

elif objdump -i 2>&1 | grep 'elf32-i386' >/dev/null 2>&1; \

then echo ''; \

else echo "***" 1>&2; \

echo "*** Error: Couldn't find an i386-elf version of GCC/binutils." 1>&2; \

echo "*** Is the directory with i386-elf-gcc in your PATH?" 1>&2; \

echo "*** If your i386-elf toolchain is installed with a command" 1>&2; \

echo "*** prefix other than 'i386-elf-', set your GCCPREFIX" 1>&2; \

echo "*** environment variable to that prefix and run 'make' again." 1>&2; \

echo "*** To turn off this error, run 'gmake GCCPREFIX= ...'." 1>&2; \

echo "***" 1>&2; exit 1; fi)

endif

# try to infer the correct QEMU

ifndef QEMU

QEMU := $(shell if which qemu-system-i386 > /dev/null; \

then echo 'qemu-system-i386'; exit; \

elif which i386-elf-qemu > /dev/null; \

then echo 'i386-elf-qemu'; exit; \

elif which qemu > /dev/null; \

then echo 'qemu'; exit; \

else \

echo "***" 1>&2; \

echo "*** Error: Couldn't find a working QEMU executable." 1>&2; \

echo "*** Is the directory containing the qemu binary in your PATH" 1>&2; \

echo "***" 1>&2; exit 1; fi)

endif

# eliminate default suffix rules

.SUFFIXES: .c .S .h

# delete target files if there is an error (or make is interrupted)

.DELETE_ON_ERROR:

# define compiler and flags

ifndef USELLVM

HOSTCC := gcc

HOSTCFLAGS := -g -Wall -O2

CC := $(GCCPREFIX)gcc

CFLAGS := -march=i686 -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc $(DEFS)

CFLAGS += $(shell $(CC) -fno-stack-protector -E -x c /dev/null >/dev/null 2>&1 && echo -fno-stack-protector)

else

HOSTCC := clang

HOSTCFLAGS := -g -Wall -O2

CC := clang

CFLAGS := -march=i686 -fno-builtin -fno-PIC -Wall -g -m32 -nostdinc $(DEFS)

CFLAGS += $(shell $(CC) -fno-stack-protector -E -x c /dev/null >/dev/null 2>&1 && echo -fno-stack-protector)

endif

CTYPE := c S

LD := $(GCCPREFIX)ld

LDFLAGS := -m $(shell $(LD) -V | grep elf_i386 2>/dev/null | head -n 1)

LDFLAGS += -nostdlib

OBJCOPY := $(GCCPREFIX)objcopy

OBJDUMP := $(GCCPREFIX)objdump

COPY := cp

MKDIR := mkdir -p

MV := mv

RM := rm -f

AWK := awk

SED := sed

SH := sh

TR := tr

TOUCH := touch -c

OBJDIR := obj

BINDIR := bin

ALLOBJS :=

ALLDEPS :=

TARGETS :=

include tools/function.mk

listf_cc = $(call listf,$(1),$(CTYPE))

# for cc

add_files_cc = $(call add_files,$(1),$(CC),$(CFLAGS) $(3),$(2),$(4))

create_target_cc = $(call create_target,$(1),$(2),$(3),$(CC),$(CFLAGS))

# for hostcc

add_files_host = $(call add_files,$(1),$(HOSTCC),$(HOSTCFLAGS),$(2),$(3))

create_target_host = $(call create_target,$(1),$(2),$(3),$(HOSTCC),$(HOSTCFLAGS))

cgtype = $(patsubst %.$(2),%.$(3),$(1))

objfile = $(call toobj,$(1))

asmfile = $(call cgtype,$(call toobj,$(1)),o,asm)

outfile = $(call cgtype,$(call toobj,$(1)),o,out)

symfile = $(call cgtype,$(call toobj,$(1)),o,sym)

# for match pattern

match = $(shell echo $(2) | $(AWK) '{for(i=1;i<=NF;i++){if(match("$(1)","^"$$(i)"$$")){exit 1;}}}'; echo $$?)

# >>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

# include kernel/user

INCLUDE += libs/

CFLAGS += $(addprefix -I,$(INCLUDE))

LIBDIR += libs

$(call add_files_cc,$(call listf_cc,$(LIBDIR)),libs,)

# -------------------------------------------------------------------

# kernel

KINCLUDE += kern/debug/ \

kern/driver/ \

kern/trap/ \

kern/mm/

KSRCDIR += kern/init \

kern/libs \

kern/debug \

kern/driver \

kern/trap \

kern/mm

KCFLAGS += $(addprefix -I,$(KINCLUDE))

$(call add_files_cc,$(call listf_cc,$(KSRCDIR)),kernel,$(KCFLAGS))

KOBJS = $(call read_packet,kernel libs)

# create kernel target

kernel = $(call totarget,kernel)

$(kernel): tools/kernel.ld

$(kernel): $(KOBJS)

@echo + ld $@

$(V)$(LD) $(LDFLAGS) -T tools/kernel.ld -o $@ $(KOBJS)

@$(OBJDUMP) -S $@ > $(call asmfile,kernel)

@$(OBJDUMP) -t $@ | $(SED) '1,/SYMBOL TABLE/d; s/ .* / /; /^$$/d' > $(call symfile,kernel)

$(call create_target,kernel)

# -------------------------------------------------------------------

# create bootblock

bootfiles = $(call listf_cc,boot)

$(foreach f,$(bootfiles),$(call cc_compile,$(f),$(CC),$(CFLAGS) -Os -nostdinc))

bootblock = $(call totarget,bootblock)

$(bootblock): $(call toobj,$(bootfiles)) | $(call totarget,sign)

@echo + ld $@

$(V)$(LD) $(LDFLAGS) -N -e start -Ttext 0x7C00 $^ -o $(call toobj,bootblock)

@$(OBJDUMP) -S $(call objfile,bootblock) > $(call asmfile,bootblock)

@$(OBJCOPY) -S -O binary $(call objfile,bootblock) $(call outfile,bootblock)

@$(call totarget,sign) $(call outfile,bootblock) $(bootblock)

$(call create_target,bootblock)

# -------------------------------------------------------------------

# create 'sign' tools

$(call add_files_host,tools/sign.c,sign,sign)

$(call create_target_host,sign,sign)

# -------------------------------------------------------------------

# create ucore.img

UCOREIMG := $(call totarget,ucore.img)

$(UCOREIMG): $(kernel) $(bootblock)

$(V)dd if=/dev/zero of=$@ count=10000

$(V)dd if=$(bootblock) of=$@ conv=notrunc

$(V)dd if=$(kernel) of=$@ seek=1 conv=notrunc

$(call create_target,ucore.img)

# >>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

$(call finish_all)

IGNORE_ALLDEPS = clean \

dist-clean \

grade \

touch \

print-.+ \

handin

ifeq ($(call match,$(MAKECMDGOALS),$(IGNORE_ALLDEPS)),0)

-include $(ALLDEPS)

endif

# files for grade script

TARGETS: $(TARGETS)

.DEFAULT_GOAL := TARGETS

.PHONY: qemu qemu-nox debug debug-nox

qemu-mon: $(UCOREIMG)

$(V)$(QEMU) -no-reboot -monitor stdio -hda $< -serial null

qemu: $(UCOREIMG)

$(V)$(QEMU) -no-reboot -parallel stdio -hda $< -serial null

log: $(UCOREIMG)

$(V)$(QEMU) -no-reboot -d int,cpu_reset -D q.log -parallel stdio -hda $< -serial null

qemu-nox: $(UCOREIMG)

$(V)$(QEMU) -no-reboot -serial mon:stdio -hda $< -nographic

TERMINAL :=gnome-terminal

debug: $(UCOREIMG)

$(V)$(QEMU) -S -s -parallel stdio -hda $< -serial null &

$(V)sleep 2

$(V)$(TERMINAL) -e "gdb -q -tui -x tools/gdbinit"

debug-nox: $(UCOREIMG)

$(V)$(QEMU) -S -s -serial mon:stdio -hda $< -nographic &

$(V)sleep 2

$(V)$(TERMINAL) -e "gdb -q -x tools/gdbinit"

.PHONY: grade touch

GRADE_GDB_IN := .gdb.in

GRADE_QEMU_OUT := .qemu.out

HANDIN := proj$(PROJ)-handin.tar.gz

TOUCH_FILES := kern/trap/trap.c

MAKEOPTS := --quiet --no-print-directory

grade:

$(V)$(MAKE) $(MAKEOPTS) clean

$(V)$(SH) tools/grade.sh

touch:

$(V)$(foreach f,$(TOUCH_FILES),$(TOUCH) $(f))

print-%:

@echo $($(shell echo $(patsubst print-%,%,$@) | $(TR) [a-z] [A-Z]))

.PHONY: clean dist-clean handin packall tags

clean:

$(V)$(RM) $(GRADE_GDB_IN) $(GRADE_QEMU_OUT) cscope* tags

-$(RM) -r $(OBJDIR) $(BINDIR)

dist-clean: clean

-$(RM) $(HANDIN)

handin: packall

@echo Please visit http://learn.tsinghua.edu.cn and upload $(HANDIN). Thanks!

packall: clean

@$(RM) -f $(HANDIN)

@tar -czf $(HANDIN) `find . -type f -o -type d | grep -v '^\.*$$' | grep -vF '$(HANDIN)'`

tags:

@echo TAGS ALL

$(V)rm -f cscope.files cscope.in.out cscope.out cscope.po.out tags

$(V)find . -type f -name "*.[chS]" >cscope.files

$(V)cscope -bq

$(V)ctags -L cscope.files

(如果想详细了解 Makefile 每行代码具体做了什么,可以参考这篇文章)

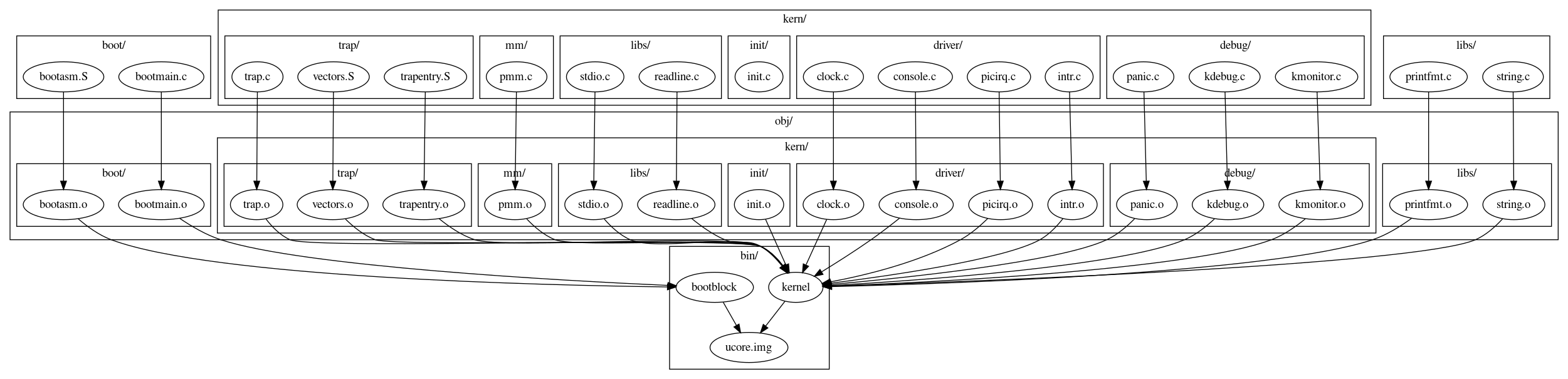

Makefile 的默认目标在第 207 行被显式指定为 205 行的 TARGETS ,而 TARGETS 的依赖为 $(TARGETS) ,这个变量在 Makefile 是空的,但是会在 tools/function.mk 中的 do_create_target 宏中被修改, do_create_target 被函数 create_target 直接调用。因此在 Makefile 中只要调用了 create_target 就会为 $(TARGETS) 增添新的一项。

经过一系列的 create_target , $(TARGETS) 最终值为:bin/kernel,bin/bootblock,bin/sign,bin/ucore.img。

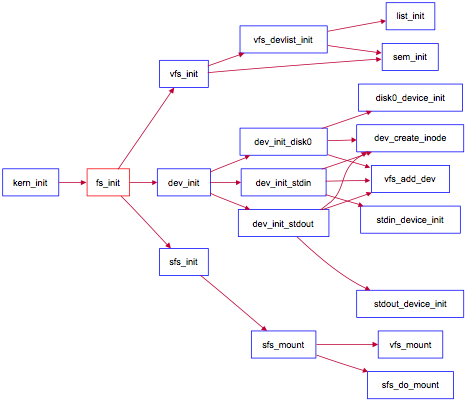

依赖图:

(参考了这篇文章)

Makefile中关键的代码为:

# 编译生成bin/kernel所需的文件

$(call add_files_cc,$(call listf_cc,$(KSRCDIR)),kernel,$(KCFLAGS))

# 链接生成bin/kernel

kernel = $(call totarget,kernel)

$(kernel): tools/kernel.ld

$(kernel): $(KOBJS)

@echo + ld $@

$(V)$(LD) $(LDFLAGS) -T tools/kernel.ld -o $@ $(KOBJS)

@$(OBJDUMP) -S $@ > $(call asmfile,kernel)

@$(OBJDUMP) -t $@ | $(SED) '1,/SYMBOL TABLE/d; s/ .* / /; /^$$/d' > $(call symfile,kernel)

$(call create_target,kernel)

# 创建bootblock

bootfiles = $(call listf_cc,boot)

$(foreach f,$(bootfiles),$(call cc_compile,$(f),$(CC),$(CFLAGS) -Os -nostdinc))

bootblock = $(call totarget,bootblock)

$(bootblock): $(call toobj,$(bootfiles)) | $(call totarget,sign)

@echo + ld $@

$(V)$(LD) $(LDFLAGS) -N -e start -Ttext 0x7C00 $^ -o $(call toobj,bootblock)

@$(OBJDUMP) -S $(call objfile,bootblock) > $(call asmfile,bootblock)

@$(OBJCOPY) -S -O binary $(call objfile,bootblock) $(call outfile,bootblock)

@$(call totarget,sign) $(call outfile,bootblock) $(bootblock)

$(call create_target,bootblock)

# 创建sign工具

$(call add_files_host,tools/sign.c,sign,sign)

$(call create_target_host,sign,sign)

# 创建ucore.img

UCOREIMG := $(call totarget,ucore.img)

$(UCOREIMG): $(kernel) $(bootblock)

$(V)dd if=/dev/zero of=$@ count=10000

$(V)dd if=$(bootblock) of=$@ conv=notrunc

$(V)dd if=$(kernel) of=$@ seek=1 conv=notrunc

$(call create_target,ucore.img)

由于之前在Lab 0的时候已经把Lab 1原始文件给make掉了,所以这里我在labcodes_answer/lab1_result目录下执行make "V="指令以获取日志输出,以便于后续分析,得到日志如下(已加注释):

# 构建 kernel 内核文件

# 初始化相关

+ cc kern/init/init.c

gcc -Ikern/init/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/init/init.c -o obj/kern/init/init.o

# 标准IO

+ cc kern/libs/stdio.c

gcc -Ikern/libs/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/libs/stdio.c -o obj/kern/libs/stdio.o

# 读行

+ cc kern/libs/readline.c

gcc -Ikern/libs/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/libs/readline.c -o obj/kern/libs/readline.o

# 异常处理相关,便于在发现错误后,调用kernel monitor。

+ cc kern/debug/panic.c

gcc -Ikern/debug/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/debug/panic.c -o obj/kern/debug/panic.o

kern/debug/panic.c: In function ‘__panic’:

kern/debug/panic.c:27:5: warning: implicit declaration of function ‘print_stackframe’; did you mean ‘print_trapframe’?

-Wimplicit-function-declaration]

27 | print_stackframe();

| ^~~~~~~~~~~~~~~~

| print_trapframe

# 提供源码和二进制对应关系的查询功能,用于显示调用栈关系。

+ cc kern/debug/kdebug.c

gcc -Ikern/debug/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/debug/kdebug.c -o obj/kern/debug/kdebug.o

# 监视器相关,提供动态分析命令的kernel monitor,便于在ucore出现bug或问题之后,能够进入kernel monitor中,查看当前调用关系。

+ cc kern/debug/kmonitor.c

gcc -Ikern/debug/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/debug/kmonitor.c -o obj/kern/debug/kmonitor.o

# 时钟控制相关

+ cc kern/driver/clock.c

gcc -Ikern/driver/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/driver/clock.c -o obj/kern/driver/clock.o

# 实现了对串口和键盘的中断方式的处理操作。

+ cc kern/driver/console.c

gcc -Ikern/driver/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/driver/console.c -o obj/kern/driver/console.o

# 中断处理相关

+ cc kern/driver/picirq.c

gcc -Ikern/driver/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/driver/picirq.c -o obj/kern/driver/picirq.o

# 实现了通过设置CPU的Eflags来屏蔽和使能中断的函数。

+ cc kern/driver/intr.c

gcc -Ikern/driver/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/driver/intr.c -o obj/kern/driver/intr.o

# 紧接着第二步初步处理后,继续完成具体的各种中断处理操作。

+ cc kern/trap/trap.c

gcc -Ikern/trap/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/trap/trap.c -o obj/kern/trap/trap.o

kern/trap/trap.c: In function ‘print_trapframe’:

kern/trap/trap.c:109:16: warning: taking address of packed member of ‘struct trapframe’ may result in an unaligned pointer value [-Waddress-of-packed-member]

109 | print_regs(&tf->tf_regs);

| ^~~~~~~~~~~~

# 包括256个中断服务例程的入口地址和第一步初步处理时先。

+ cc kern/trap/vectors.S

gcc -Ikern/trap/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/trap/vectors.S -o obj/kern/trap/vectors.o

# 紧接着第一步初步处理后,进一步完成第二步初步处理;并且又恢复中断上下文的处理,即中断处理完毕后的返回准备操作。

+ cc kern/trap/trapentry.S

gcc -Ikern/trap/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/trap/trapentry.S -o obj/kern/trap/trapentry.o

# 设定ucore操作系统在段机制中要用到的全局变量:任务状态栏ts,全局描述符表gdt[],加载全局描述符表寄存器的函数lgdt,临时的内核栈stack(),以及对全局描述符表和任务状态段的初始化函数gdt_init。

+ cc kern/mm/pmm.c

gcc -Ikern/mm/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Ikern/debug/ -Ikern/driver/ -Ikern/trap/ -Ikern/mm/ -c kern/mm/pmm.c -o obj/kern/mm/pmm.o

# 字符串相关

+ cc libs/string.c

gcc -Ilibs/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -c libs/string.c -o obj/libs/string.o

# 格式化输出

+ cc libs/printfmt.c

gcc -Ilibs/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -c libs/printfmt.c -o obj/libs/printfmt.o

# 建立链接

+ ld bin/kernel

ld -m elf_i386 -nostdlib -T tools/kernel.ld -o bin/kernel obj/kern/init/init.o obj/kern/libs/stdio.o obj/kern/libs/readline.o obj/kern/debug/panic.o obj/kern/debug/kdebug.o obj/kern/debug/kmonitor.o obj/kern/driver/clock.o obj/kern/driver/console.o obj/kern/driver/picirq.o obj/kern/driver/intr.o obj/kern/trap/trap.o obj/kern/trap/vectors.o obj/kern/trap/trapentry.o obj/kern/mm/pmm.o obj/libs/string.o obj/libs/printfmt.o

/*

-m 模拟指定的连接器elf_i386

-nostdlib 不使用标准库

-T 指定命令文件为tools/kernel.ld

-o 指定输出文件名字为kernel

*/

# 构建 bootblock

# 定义并实现bootloader最先执行的start函数,此函数进行了一定的初始化,完成了从实模式到保护模式的转换,并调用了bootmain.c中的bootmain函数。

+ cc boot/bootasm.S

gcc -Iboot/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Os -nostdinc -c boot/bootasm.S -o obj/boot/bootasm.o

/*

-ggdb:生成可供gdb使用的调试信息。这样才能用qemu+gdb来调试bootloader或ucore

-m32:生成适用于32位环境的代码。我们用的模拟硬件是32位的80386,所以ucore也要是32位的软件

-gstabs:生成stabs格式的调试信息。ucore的monitor可以显示出便于开发者阅读的函数调用栈信息

-nostdinc:不使用标准库。标准库是给应用程序用的,我们是编译ucore内核,OS内核是提供服务的,所以所有的服务要自给自足。

-fno-stack-protector:不生成用于检测缓冲区溢出的代码。

-Os:为减小代码大小而进行优化。根据硬件spec,主引导扇区只有512字节,我们写的简单bootloader的最终大小不能大于510字节。

-I:添加搜索头文件的路径。

-Wall:产生尽可能多的警告信息。

-fno-builtin:除非用__builtin__前缀,否则不进行builtin函数的优化

*/

# 主程序,定义并实现了bootmain函数,实现了通过屏幕、串口和并口显示字符串,bootmain函数加载ucore操作系统到内存,然后跳到ucore的入口处执行。

+ cc boot/bootmain.c

gcc -Iboot/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Os -nostdinc -c boot/bootmain.c -o obj/boot/bootmain.o

# 规范化工具,用于生成一个规范的硬盘主引导扇区。

+ cc tools/sign.c

# 使用 gcc 将 sign.c 编译成可执行文件

gcc -Itools/ -g -Wall -O2 -c tools/sign.c -o obj/sign/tools/sign.o

gcc -g -Wall -O2 obj/sign/tools/sign.o -o bin/sign

# 使用 ld 命令链接 bootasm.o、bootmain.o 至 bootblock.out

+ ld bin/bootblock

ld -m elf_i386 -nostdlib -N -e start -Ttext 0x7C00 obj/boot/bootasm.o obj/boot/bootmain.o -o obj/bootblock.o

'obj/bootblock.out' size: 500 bytes

build 512 bytes boot sector: 'bin/bootblock' success!

/*

-m:模拟指定的连接器为elf_i386

-N:指定读取/写入文本和数据段

-e:使用指定的符号start作为程序的初始执行点

-Ttext:使用指定的地址0x7C00作为文本段的起始点

-nonstdlib:不使用标准库

*/

# 构建 ucore.img

# 使用 dd 工具创建 ucore.img 空文件

dd if=/dev/zero of=bin/ucore.img count=10000

10000+0 records in

10000+0 records out

5120000 bytes (5.1 MB, 4.9 MiB) copied, 0.0445599 s, 115 MB/s

# 使用dd工具将bin/bootblock写入ucore.img, 参数conv=notrunc表示不截断输出文件

dd if=bin/bootblock of=bin/ucore.img conv=notrunc

1+0 records in

1+0 records out

512 bytes copied, 0.0001275 s, 4.0 MB/s

# 使用dd工具将bin/kernel写入ucore.img起始的1个block后,即bootblock后, 参数seek=1表示从输出文件开头跳过1个block开始写入

dd if=bin/kernel of=bin/ucore.img seek=1 conv=notrunc

154+1 records in

154+1 records out

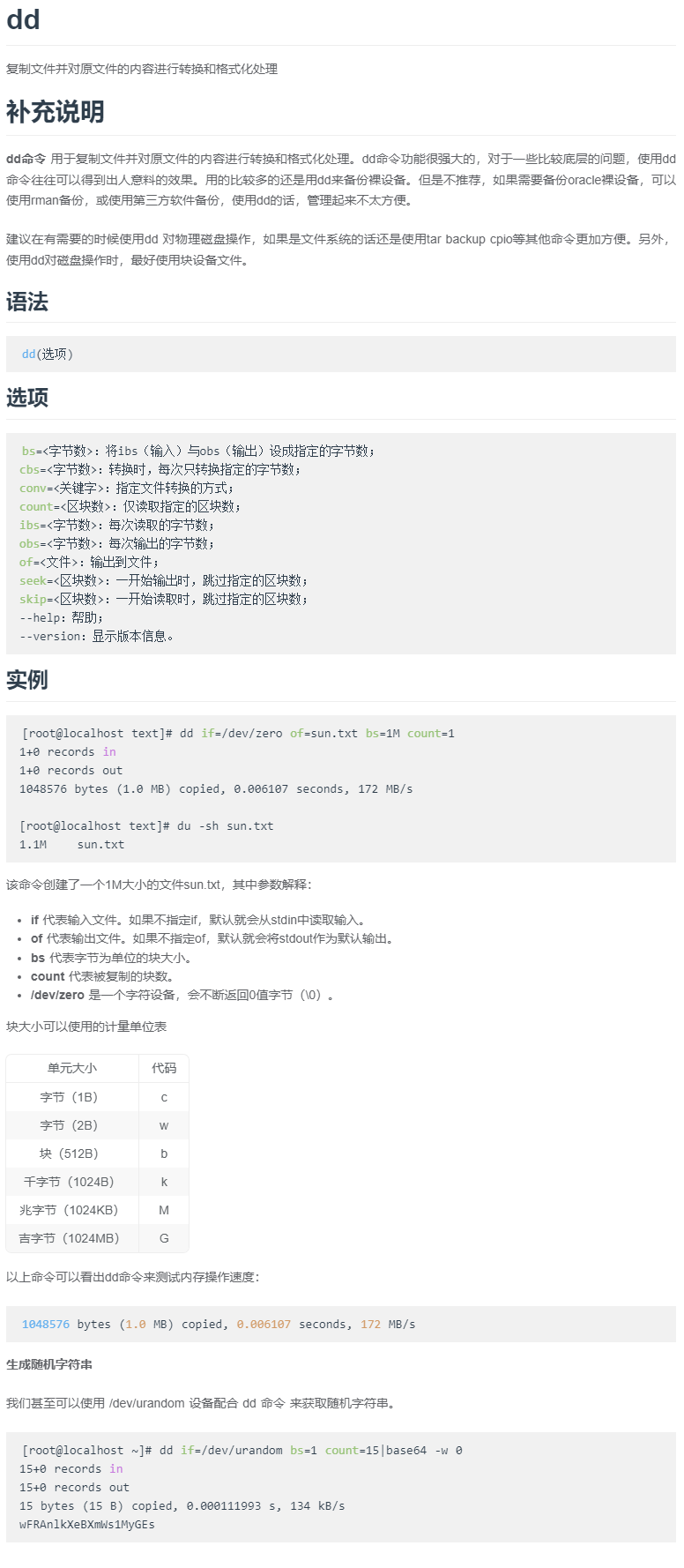

78968 bytes (79 kB, 77 KiB) copied, 0.0009979 s, 79.1 MB/s由以上输出可以分析出构建ucore.img时大致进行了以下操作:

- 编译了若干内核文件,构建出内核

kernel, - 生成

bootblock引导程序 - 编译

bootasm.Sbootmain.c,链接obj/bootblock.o - 编译

sign.c生成sign.o工具 - 使用

sign.o工具规范化bootblock.o,生成bin/bootblock引导扇区 - 生成

ucore.img虚拟磁盘 - dd 初始化一个大小为

5120000bytes且内容为 0 的文件 - dd 拷贝

bin/bootblock引导文件到ucore.img的第一个扇区 - dd 拷贝

bin/kernel内核文件到ucore.img第二个扇区往后的空间

补充:dd 命令的使用

问题二解答

题目:一个被系统认为是符合规范的硬盘主引导扇区的特征是什么?

通常我们将包含MBR(主引导记录)引导代码的扇区称为主引导扇区。通常由 3 部分组成:主引导程序(MBR,占 446 字节)、磁盘分区表项(占 4×16 个字节,负责说明磁盘上的分区情况)、结束标志位(占 2 个字节,其值为55 AA)。

上题中的sign.o工具可以规范化bootblock.o,生成bin/bootblock引导扇区,因此查看sign.c源代码进行分析,代码如下(已加注释):

#include <stdio.h>

#include <errno.h>

#include <string.h>

#include <sys/stat.h>

int

main(int argc, char *argv[]) {

struct stat st;

// 命令参数检查

if (argc != 3) {

fprintf(stderr, "Usage: <input filename> <output filename>\n");

return -1;

}

// 读取文件头

if (stat(argv[1], &st) != 0) {

fprintf(stderr, "Error opening file '%s': %s\n", argv[1], strerror(errno));

return -1;

}

// 输出文件大小

printf("'%s' size: %lld bytes\n", argv[1], (long long)st.st_size);

// 文件大小检查,超过510字节则报错,因为最后2个字节要用作结束标志位

if (st.st_size > 510) {

fprintf(stderr, "%lld >> 510!!\n", (long long)st.st_size);

return -1;

}

char buf[512]; // 定义缓冲区

memset(buf, 0, sizeof(buf)); // 初始化为0

FILE *ifp = fopen(argv[1], "rb"); // 读入源文件

int size = fread(buf, 1, st.st_size, ifp); // 获取文件大小

// 文件大小检查

if (size != st.st_size) {

fprintf(stderr, "read '%s' error, size is %d.\n", argv[1], size);

return -1;

}

fclose(ifp); // 释放文件

// 写入结束标志位

buf[510] = 0x55;

buf[511] = 0xAA;

// 写入目标文件

FILE *ofp = fopen(argv[2], "wb+");

size = fwrite(buf, 1, 512, ofp);

// 文件大小检查

if (size != 512) {

fprintf(stderr, "write '%s' error, size is %d.\n", argv[2], size);

return -1;

}

fclose(ofp); // 释放文件

// 正常返回

printf("build 512 bytes boot sector: '%s' success!\n", argv[2]);

return 0;

}

由上述代码分析可以得出符合规范的硬盘主引导扇区的特征为:

- 总大小为

512 bytes - 内容不超过

510 bytes - 最后

2 bytes为0x55 0xAA

练习 2:使用 qemu 执行并调试 lab1 中的软件

本练习任务:

- 从 CPU 加电后执行的

第一条指令开始,单步跟踪BIOS的执行。 - 在初始化位置

0x7c00设置实地址断点,测试断点正常。 - 从

0x7c00开始跟踪代码运行,将单步跟踪反汇编得到的代码与 bootasm.S 和 bootblock.asm进行比较。 - 自己找一个 bootloader 或内核中的代码位置,设置断点并进行测试。

补充材料:

我们主要通过硬件模拟器 qemu 来进行各种实验。在实验的过程中我们可能会遇上各种各样的问题,调试是必要的。qemu 支持使用 gdb 进行的强大而方便的调试。所以用好 qemu 和 gdb 是完成各种实验的基本要素。

默认的 gdb 需要进行一些额外的配置才进行 qemu 的调试任务。qemu 和 gdb 之间使用网络端口 1234 进行通讯。在打开 qemu 进行模拟之后,运行 gdb 并输入:

target remote localhost:1234 // 或 target remote 127.0.0.1:1234即可连接 qemu,此时 qemu 会进入暂停状态,等待 gdb 的命令。这点我们在Lab 0已经了解过。

gdb 的地址断点

在 gdb 命令行中,使用 b *[地址]便可以在指定内存地址设置断点,当 qemu 中的 cpu 执行到指定地址时,便会将控制权交给 gdb。

关于代码的反汇编

有可能 gdb 无法正确获取当前 qemu 执行的汇编指令,通过如下配置可以在每次 gdb 命令行前强制反汇编当前的指令,在 gdb 命令行或配置文件中添加:

define hook-stop

x/i $pc

endgdb 的单步命令

在 gdb 中,有next, nexti, step, stepi等指令来单步调试程序,它们功能各不相同,区别在于单步的跨度上。

next 单步到程序源代码的下一行,不进入函数。

nexti 单步一条机器指令,不进入函数。

step 单步到下一个不同的源代码行(包括进入函数)。

stepi 单步一条机器指令。问题一解答

题目:从 CPU 加电后执行的第一条指令开始,单步跟踪 BIOS 的执行。

我们在Lab 0的时候已经配置好了gdbinit,现在可以直接使用。

在lab1目录下执行make debug进行调试。(在此过程中如果遇到/bin/sh: 1: gnome-terminal: not found报错,执行sudo apt-get install gnome-terminal进行安装。)

正常执行如下图:

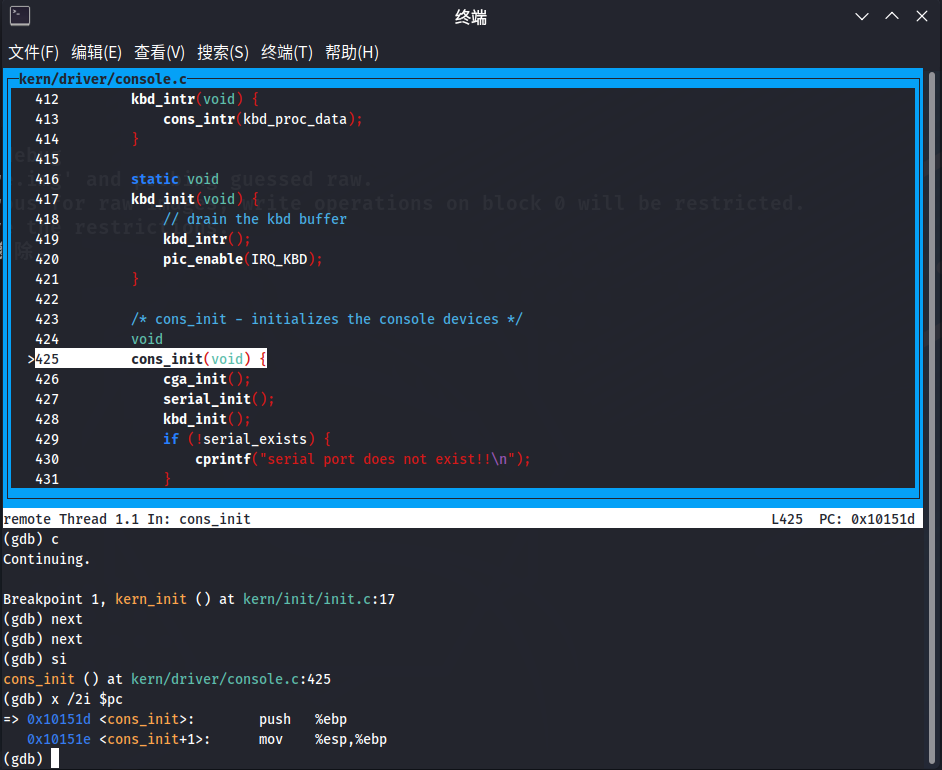

接下来首先执行continue开始调试,之后使用next和si语句进行单步调试,最后使用x /2i $pc指令查看当前位置附近的两条汇编代码。

问题二解答

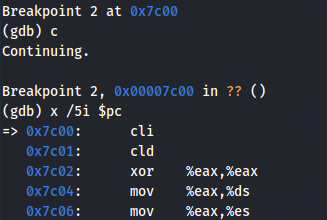

题目:在初始化位置 0x7c00 设置实地址断点,测试断点正常。

首先使用b *0x7c00指令在该地址处设下断点,然后使用c指令让程序执行至断点位置,最后使用x /5i $pc指令查看当前地址附近的 5 条汇编代码。如下图所示测试断点正常。

问题三解答

题目:从 0x7c00 开始跟踪代码运行,将单步跟踪反汇编得到的代码与 bootasm.S 和 bootblock.asm 进行比较。

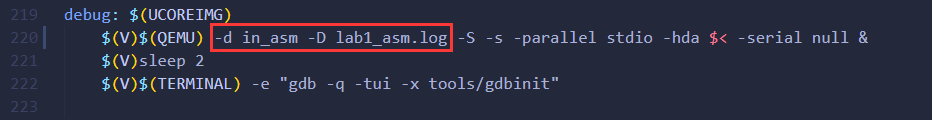

首先打开lab1/Makefile文件,找到如图所示位置并添加-d in_asm -D lab1_asm.log参数,这样后续我们进行调试时就可以自动将运行的汇编指令保存在lab1_asm.log 中,方便对比。

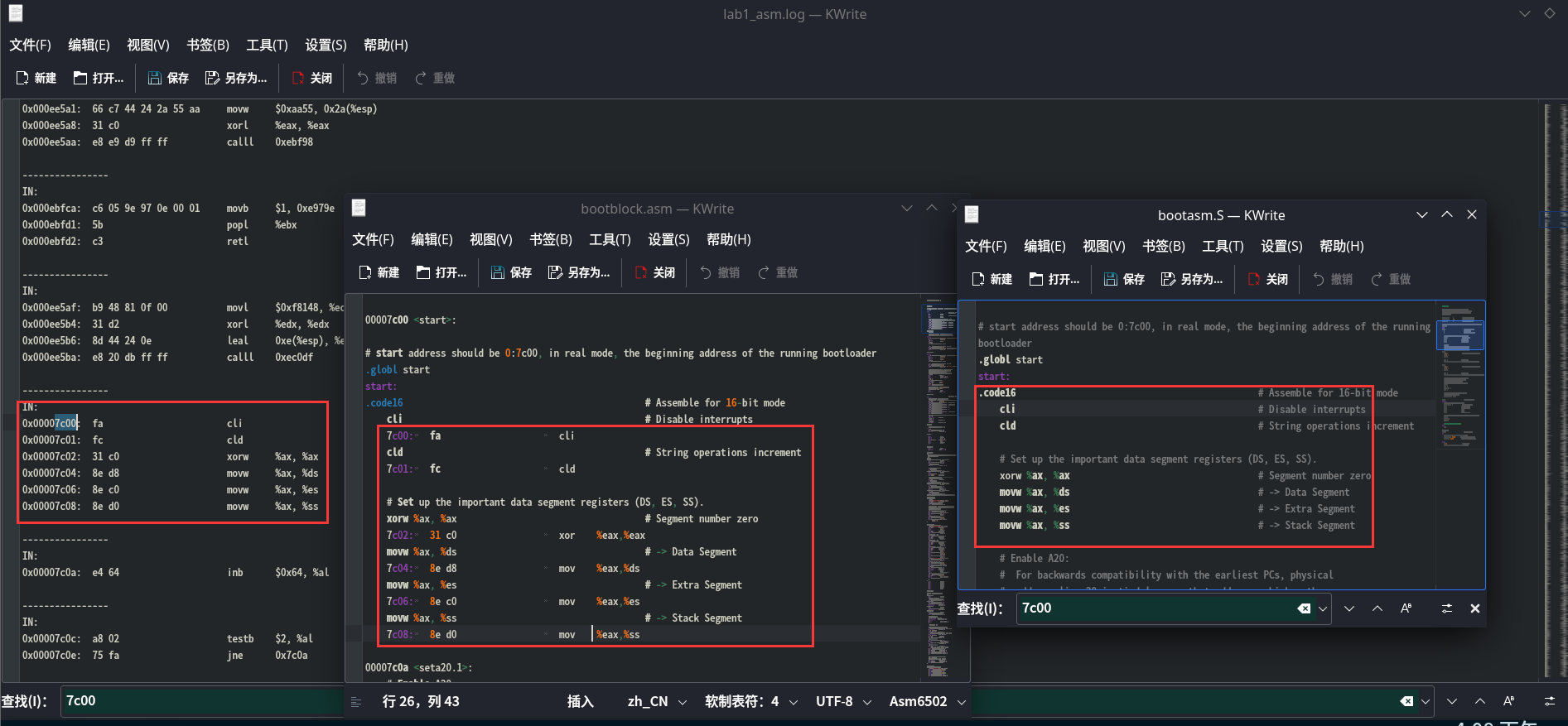

修改完成后继续执行make debug,之后我们会看到lab1目录下多了一个新文件lab1_asm.log,将其打开,之后打开boot/bootasm.S,再打开obj/bootblock.asm,将三者进行比较。

可以看到三者的汇编代码本质上是对应一致的。

问题四解答

题目:自己找一个 bootloader 或内核中的代码位置,设置断点并进行测试。

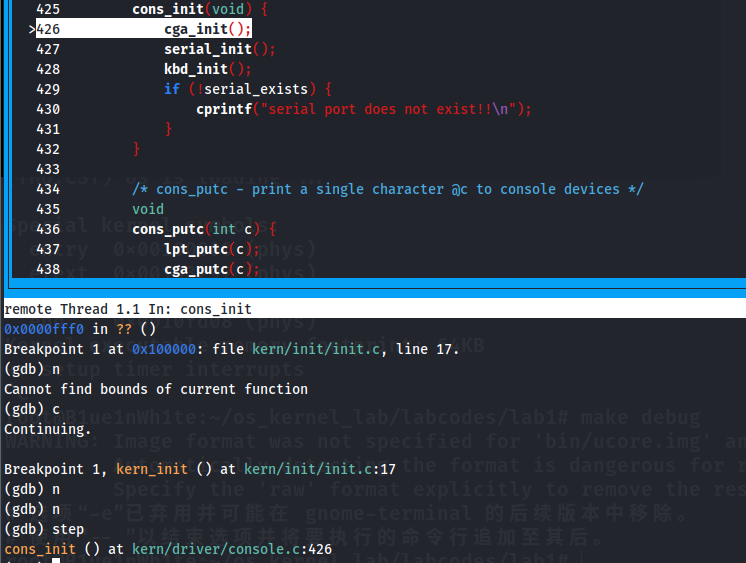

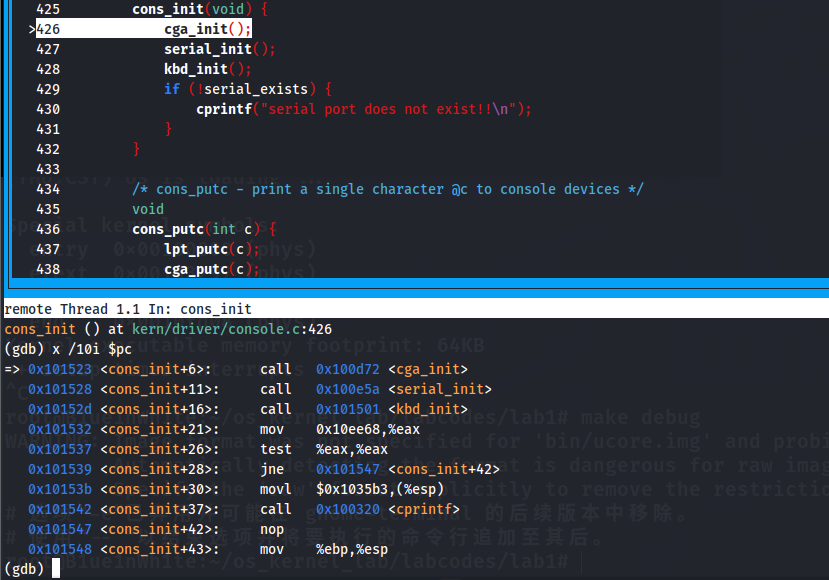

这题自由度比较高,我就选择cons_init这个函数进行调试吧。

可以看到汇编代码内call的函数是和源代码所指示的一一对应的,这部分应该是常量初始化过程。

练习 3:分析 bootloader 进入保护模式的过程

BIOS 将通过读取硬盘主引导扇区到内存,并转跳到对应内存中的位置执行 bootloader。请分析 bootloader 是如何完成从实模式进入保护模式的。

本练习任务:

- 为何开启

A20,以及如何开启A20 - 如何初始化

GDT表 - 如何

使能和进入保护模式

提示:需要阅读小节保护模式和分段机制和lab1/boot/bootasm.S源码。

问题一解答

题目:为何开启 A20,以及如何开启 A20?

建议先阅读附录 A“关于 A20 Gate”

- 为何开启 A20

i8086提供了 20 根地址线,但寄存器只有 16 位,因此 CPU 只能访问 1MB 以内的空间。CPU 想获取数据,需对 segment 左移 4 位,再加上 offest ,最终形成一个 20 位 的地址:address = segment << 4 | offset。- 但按这种方式计算出的地址的最大值为

1088KB,超过 20 根地址线所能表示的范围(1MB=1024KB),会发生回卷(memory wraparound)(和整数溢出有点类似)。但下一代的基于i80286的计算机系统提供了 24 根地址线,当 CPU 计算出的地址超过 1MB 时不会发生回卷,这就造成了向下不兼容。为了保持完全的向下兼容性,IBM 在计算机系统上加个硬件逻辑来模仿早期的回绕特征,而这就是A20 Gate,通过这个模块我们在实模式下将第20位的地址线限制为 0,这样 CPU 就无法访问超过 1MB 的空间了。 A20 Gate的方法是把 A20 地址线控制和键盘控制器的一个输出进行AND操作,这样来控制 A20 地址线的打开(使能)和关闭(屏蔽/禁止)。一开始时 A20 地址线控制是被屏蔽的(总为 0),直到系统软件通过一定的 IO 操作去打开它。当 A20 地址线控制禁止时,则程序就像在i8086中运行,1MB 以上的地址不可访问;保护模式下 A20 地址线控制打开,之后内存寻址将不会发生回卷,这时CPU可以充分使用32位4G内存的寻址能力(内存管理能力)。- 如何开启 A20

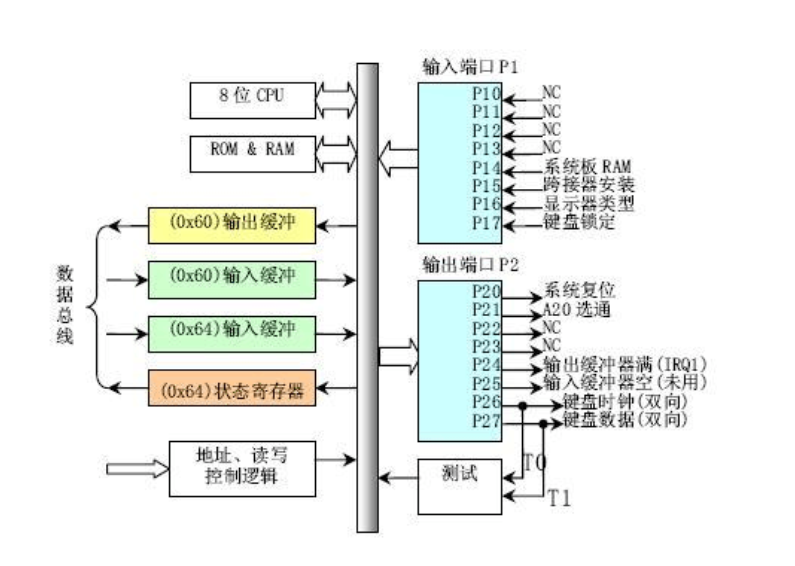

在当前环境中,所用到的键盘控制器 8042 的 IO 端口只有

0x60和0x64两个端口。8042 通过这些端口给键盘控制器或键盘发送命令或读取状态。输出端口P2用于特定目的。位 0(P20 引脚)用于实现 CPU 复位操作,位 1(P21 引脚)用于控制 A20 信号线的开启与否。我们要操作的位置是输出端口 P2 的位 1,写入方法为:向64h发送0xd1命令,表示我们想要修改端口P2;然后向60h发送想要写入的数据,这里是0xdf,实现端口P2的位1(即P21)置1。

- 当我们想要向 8042 输出端口进行写操作的时候,在键盘缓冲区中或许还有别的数据尚未处理,因此必须首先处理这些数据。

- 激活 A20 地址线的流程为: 1.禁止中断;2.等待,直到 8042 Input buffer 为空为止; 3.发送 Write 8042 Output Port 命令到 8042 Input buffer;4.等待,直到 8042 Input buffer 为空为止;5.向端口 P2 写入数据。

从程序角度分析,当从初始位置%cs=0 $pc=0x7c00进入后,首先清理环境(包括将 flag 置 0 和将段寄存器置 0):

# start address should be 0:7c00, in real mode, the beginning address of the running bootloader

.globl start

start:

.code16 # Assemble for 16-bit mode

cli # Disable interrupts

cld # String operations increment

# Set up the important data segment registers (DS, ES, SS).

xorw %ax, %ax # Segment number zero

movw %ax, %ds # -> Data Segment

movw %ax, %es # -> Extra Segment

movw %ax, %ss # -> Stack Segment

开启A20的汇编代码如下(已加注释):

# Enable A20:

# For backwards compatibility with the earliest PCs, physical

# address line 20 is tied low, so that addresses higher than

# 1MB wrap around to zero by default. This code undoes this.

seta20.1:

# 读取0x64端口

inb $0x64, %al # Wait for not busy(8042 input buffer empty).

testb $0x2, %al # 读取到2则表明缓冲区中没有数据

jnz seta20.1

# 接下来往0x64写入0xd1,表示请求修改8042的端口P2

movb $0xd1, %al # 0xd1 -> port 0x64

outb %al, $0x64 # 0xd1 means: write data to 8042's P2 port

seta20.2:

# 接下来继续等待input buffer为空

inb $0x64, %al # Wait for not busy(8042 input buffer empty).

testb $0x2, %al

jnz seta20.2

# 往0x60端口写入0xdf,表示将端口P2的位1(A20选通使能)置为1,开启A20

movb $0xdf, %al # 0xdf -> port 0x60

outb %al, $0x60 # 0xdf = 11011111, means set P2's A20 bit(the 1 bit) to 1至此,A20 开启,CPU 进入保护模式之后可以充分使用32位4G内存的寻址能力。

问题二解答

题目:如何初始化 GDT 表

GDT(Global Descriptor Table, 全局描述表)。同实模式一样,在保护模式下,对内存的访问仍采用短地址加偏移地址的方式。其内存的管理方式有两种,段模式和页模式。在保护模式下,对于一个段的描述包括:Base Address(基址),Limit(段的最大长度),Access(权限),这三个数据加在一起被放在一个 64 bit 的数据结构中,被称为段描述符。而由于寄存器为 16 bit,很明显,我们无法直接通过 16 bit 长度的寄存器来直接使用 64 bit 的段描述符。而对此的解决方案便是将这些段描述符放入一个全局数组中,将段寄存器中的值作为下标索引(段寄存器中的高 13 bit 的内容作为索引)来间接引用。而这个全局数组便是 GDT。

GDT 相关的汇编代码:

# Bootstrap GDT

.p2align 2 # force 4 byte alignment

gdt:

SEG_NULLASM # null seg

SEG_ASM(STA_X|STA_R, 0x0, 0xffffffff) # code seg for bootloader and kernel

SEG_ASM(STA_W, 0x0, 0xffffffff) # data seg for bootloader and kernel

gdtdesc:

.word 0x17 # sizeof(gdt) - 1

.long gdt # address gdt

SEG_NULLASM设置表中第一项为NULLSEG_ASM(STA_X|STA_R, 0x0, 0xffffffff)设置表中第二项为代码段描述符,可读可执行SEG_ASM(STA_W, 0x0, 0xffffffff)设置表中第三项为数据段描述符,可写

问题三解答

题目:如何使能和进入保护模式

x86 引入了几个新的控制寄存器 (Control Registers) cr0 cr1 … cr7 ,每个长 32 位。这其中的某些寄存器的某些位被用来控制 CPU 的工作模式,其中 cr0 的最低位,就是用来控制 CPU 是否处于保护模式的。因为控制寄存器不能直接拿来运算,所以需要通过通用寄存器来进行一次存取,设置 cr0 最低位为1之后就已经进入保护模式。但是由于现代 CPU 的一些特性 (乱序执行和分支预测等),在转到保护模式之后 CPU 可能仍然在跑着实模式下的代码,这显然会造成一些问题。因此必须强制 CPU 清空一次缓冲,最有效的方法就是进行一次long jump。

以下是相关的汇编代码(已加注释):

# Switch from real to protected mode, using a bootstrap GDT

# and segment translation that makes virtual addresses

# identical to physical addresses, so that the

# effective memory map does not change during the switch.

# 载入GDT

lgdt gdtdesc

# 将cr0寄存器PE置1,开启保护模式

movl %cr0, %eax

orl $CR0_PE_ON, %eax

movl %eax, %cr0

# Jump to next instruction, but in 32-bit code segment.

# Switches processor into 32-bit mode.

# 通过长跳转更新cs的基地址

ljmp $PROT_MODE_CSEG, $protcseg

# 设置段寄存器,建立堆栈

.code32 # Assemble for 32-bit mode

protcseg:

# Set up the protected-mode data segment registers

movw $PROT_MODE_DSEG, %ax # Our data segment selector

movw %ax, %ds # -> DS: Data Segment

movw %ax, %es # -> ES: Extra Segment

movw %ax, %fs # -> FS

movw %ax, %gs # -> GS

movw %ax, %ss # -> SS: Stack Segment

# Set up the stack pointer and call into C. The stack region is from 0--start(0x7c00)

movl $0x0, %ebp

movl $start, %esp

# 转到保护模式完成,call进入bootmain

call bootmain

# If bootmain returns (it shouldn't), loop.

spin:

jmp spin

bootloader 从实模式进入保护模式的过程:

- 在开启 A20 之后,加载了

GDT全局描述符表,它是被静态储存在引导区中的,载入即可。接着,将cr0寄存器的bit 0置为1,标志着从实模式转换到保护模式。 - 由于我们无法直接或间接 mov 一个数据到 cs 寄存器中,而刚刚开启保护模式时,cs 的影子寄存器还是实模式下的值,所以需要告诉 CPU 加载新的段信息。

长跳转可以设置cs寄存器,CPU 发现了 cr0 寄存器第 0 位的值是 1,就会按 GDTR 的指示找到全局描述符表 GDT,然后根据索引值 把新的段描述符信息加载到 cs 影子寄存器,当然前提是进行了一系列合法的检查。所以使用一个长跳转ljmp $PROT_MODE_CSEG, $protcseg以更新cs基地址,至此 CPU 真正进入了保护模式,拥有了 32 位的处理能力。 - 进入保护模式后,设置ds,es,fs,gs,ss段寄存器,建立堆栈(0~0x7c00),最后进入

bootmain函数。

练习 4:分析 bootloader 加载 ELF 格式的 OS 的过程。

通过阅读bootmain.c,了解 bootloader如何加载ELF文件。通过分析源代码和通过qemu来运行并调试 bootloader&OS。

本练习任务:

- bootloader 如何

读取硬盘扇区的? - bootloader 是如何

加载ELF格式的OS?

提示:可阅读小节硬盘访问概述,ELF 文件格式概述这两小节了解。

问题一解答

题目:bootloader 如何读取硬盘扇区的?

当前硬盘数据是储存到硬盘扇区中的,一个扇区大小为 512 字节。读一个扇区的流程大致如下:

- 等待磁盘准备好

- 发出读取扇区的命令

- 等待磁盘准备好

- 把磁盘扇区数据读到指定内存

boot/bootmain.c中相关的代码为(已加注释):

/* waitdisk - wait for disk ready */

static void

waitdisk(void) {

// 判断磁盘是否处于忙碌状态

while ((inb(0x1F7) & 0xC0) != 0x40)

/* do nothing */;

}

/* readsect - read a single sector at @secno into @dst */

static void

readsect(void *dst, uint32_t secno) {

//等待磁盘准备好

waitdisk();

// 设置磁盘参数

outb(0x1F2, 1); // 往0X1F2地址中写入要读取的扇区数,由于此处需要读一个扇区,因此参数为1

// 0x1F3-0x1F6 设置LBA模式的参数

outb(0x1F3, secno & 0xFF); // 输入LBA参数的0-7位

outb(0x1F4, (secno >> 8) & 0xFF); // 输入LBA参数的8-15位

outb(0x1F5, (secno >> 16) & 0xFF); // 输入LBA参数的16-23位

outb(0x1F6, ((secno >> 24) & 0xF) | 0xE0); // 输入LBA参数的24-27位(对应到0-3位),第四位为0表示从主盘读取,其余位被强制置为1

outb(0x1F7, 0x20); // 发出读取扇区的指令

//等待磁盘准备好

waitdisk();

// 从0x1F0端口处读数据,除以4是因为此处是以4个字节为单位的

insl(0x1F0, dst, SECTSIZE / 4);

}各地址代表的寄存器意义如下:

- 0x1F0 R,当 0x1F7 不为忙状态时可以读

- 0x1F2 R/W,扇区数寄存器,记录操作的扇区数

- 0x1F3 R/W,扇区号寄存器,记录操作的起始扇区号

- 0x1F4 R/W,柱面号寄存器,记录柱面号的低 8 位

- 0x1F5 R/W,柱面号寄存器,记录柱面号的高 8 位

- 0x1F6 R/W,驱动器/磁头寄存器,记录操作的磁头号、驱动器号和寻道方式,前 4 位代表逻辑扇区号的高 4 位,DRV = 0/1 代表主/从驱动器,LBA = 0/1 代表 CHS/LBA 方式。

- 0x1F7 R,状态寄存器,第 6、7 位分别代表驱动器准备好/驱动器忙

- 0x1F8 W,命令寄存器,0x20 命令代表读取扇区

readseg封装了readsect,通过迭代使其可以读取任意长度的内容,代码如下:

/* *

* readseg - read @count bytes at @offset from kernel into virtual address @va,

* might copy more than asked.

* */

static void

readseg(uintptr_t va, uint32_t count, uint32_t offset) {

uintptr_t end_va = va + count;

// round down to sector boundary

va -= offset % SECTSIZE;

// translate from bytes to sectors; kernel starts at sector 1

uint32_t secno = (offset / SECTSIZE) + 1;

// If this is too slow, we could read lots of sectors at a time.

// We'd write more to memory than asked, but it doesn't matter --

// we load in increasing order.

for (; va < end_va; va += SECTSIZE, secno ++) {

readsect((void *)va, secno);

}

}问题二解答

题目:bootloader 是如何加载 ELF 格式的 OS?

首先看elfhdr、proghdr相关的信息,libs/elf.h代码如下(已加注释):

#ifndef __LIBS_ELF_H__

#define __LIBS_ELF_H__

#include <defs.h>

#define ELF_MAGIC 0x464C457FU // 小端格式下"\x7FELF"

/* 文件头 */

struct elfhdr {

uint32_t e_magic; // 必须等于ELF_MAGIC魔数

uint8_t e_elf[12]; // 12 字节,每字节对应意义如下:

// 0 : 1 = 32 位程序;2 = 64 位程序

// 1 : 数据编码方式,0 = 无效;1 = 小端模式;2 = 大端模式

// 2 : 只是版本,固定为 0x1

// 3 : 目标操作系统架构

// 4 : 目标操作系统版本

// 5 ~ 11 : 固定为 0

uint16_t e_type; // 1=可重定位, 2=可执行, 3=共享对象, 4=核心镜像

uint16_t e_machine; // 3=x86, 4=68K, etc.

uint32_t e_version; // 文件版本,总为1

uint32_t e_entry; // 程序入口地址(如果可执行)

uint32_t e_phoff; // 程序段表头相对elfhdr偏移位置

uint32_t e_shoff; // 节头表相对elfhdr偏移量

uint32_t e_flags; // 处理器特定标志,通常为0

uint16_t e_ehsize; // 这个ELF头的大小

uint16_t e_phentsize; // 程序头部长度

uint16_t e_phnum; // 段个数

uint16_t e_shentsize; // 节头部长度

uint16_t e_shnum; // 节头部个数

uint16_t e_shstrndx; // 节头部字符索引

};

/* 程序段表头 */

struct proghdr {

uint32_t p_type; // 段类型

// 1 PT_LOAD : 可载入的段

// 2 PT_DYNAMIC : 动态链接信息

// 3 PT_INTERP : 指定要作为解释程序调用的以空字符结尾的路径名的位置和大小

// 4 PT_NOTE : 指定辅助信息的位置和大小

// 5 PT_SHLIB : 保留类型,但具有未指定的语义

// 6 PT_PHDR : 指定程序头表在文件及程序内存映像中的位置和大小

// 7 PT_TLS : 指定线程局部存储模板

uint32_t p_offset; // 段相对文件头的偏移值

uint32_t p_va; // 段的第一个字节将被放到内存中的虚拟地址

uint32_t p_pa; //段的第一个字节在内存中的物理地址

uint32_t p_filesz; //段在文件中的长度

uint32_t p_memsz; // 段在内存映像中占用的字节数

uint32_t p_flags; //可读可写可执行标志位。

uint32_t p_align; //段在文件及内存的对齐方式

};

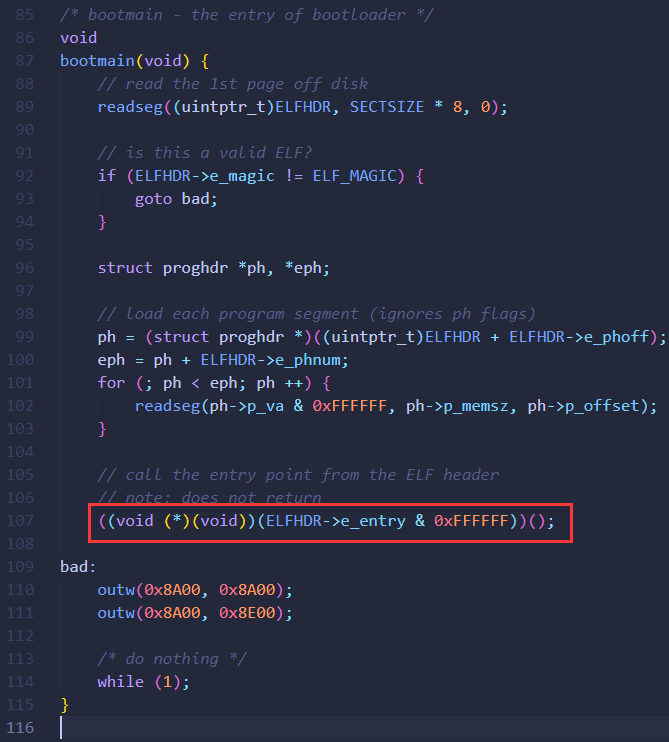

#endif /* !__LIBS_ELF_H__ */结合boot/bootmain.c代码分析如下(已加注释):

#define SECTSIZE 512

#define ELFHDR ((struct elfhdr *)0x10000)

/* bootmain - the entry of bootloader */

void

bootmain(void) {

// read the 1st page off disk

readseg((uintptr_t)ELFHDR, SECTSIZE * 8, 0); //bootloader先将ELF格式的OS加载到地址0x10000

// is this a valid ELF?

// 通过储存在头部的幻数判断读入的ELF文件是否合法

if (ELFHDR->e_magic != ELF_MAGIC) {

goto bad;

}

struct proghdr *ph, *eph;

// load each program segment (ignores ph flags)

// 按照描述表将ELF文件中数据载入内存,将ELF中每个段都加载到特定的地址

// ELF文件0x1000位置后面的0xd1ec比特被载入内存0x00100000

// ELF文件0xf000位置后面的0x1d20比特被载入内存0x0010e000

ph = (struct proghdr *)((uintptr_t)ELFHDR + ELFHDR->e_phoff);

eph = ph + ELFHDR->e_phnum;

for (; ph < eph; ph ++) {

readseg(ph->p_va & 0xFFFFFF, ph->p_memsz, ph->p_offset);

}

// call the entry point from the ELF header

// note: does not return

// 跳转至ELF文件的程序入口点

((void (*)(void))(ELFHDR->e_entry & 0xFFFFFF))();

bad:

outw(0x8A00, 0x8A00);

outw(0x8A00, 0x8E00);

/* do nothing */

while (1);

}

加载 ELF 格式的 OS 的大致流程为:

- 读取 ELF 的头部

- 判断 ELF 文件是否合法

- 找到 ELF 有关内存位置的描述表

- 按照这个描述表将数据载入内存

- 根据 ELF 头部储存的入口信息找到内核的入口并跳转

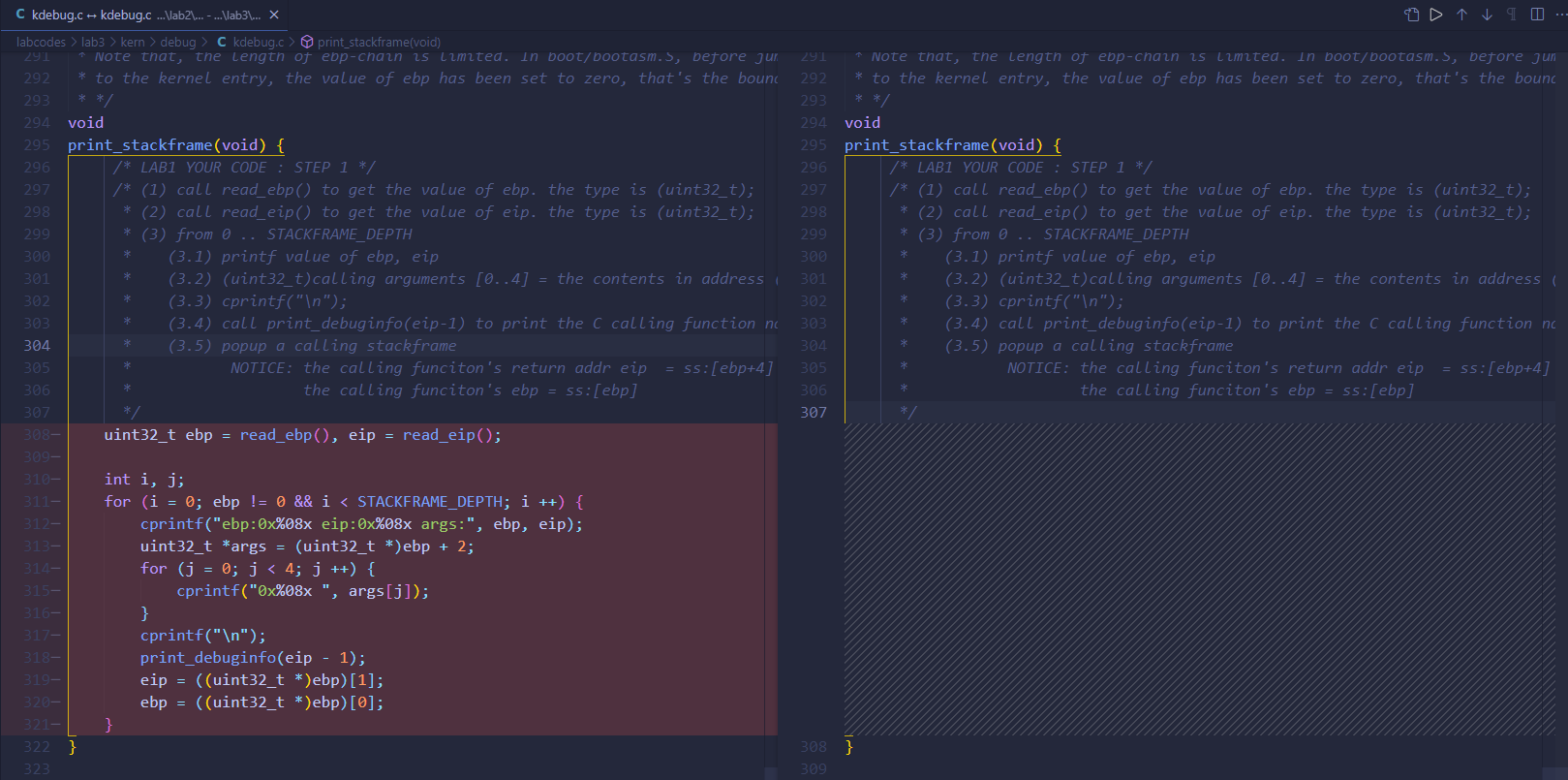

练习 5:实现函数调用堆栈跟踪函数 (需要编程)

我们需要在 lab1 中完成kdebug.c中函数print_stackframe的实现,可以通过函数print_stackframe来跟踪函数调用堆栈中记录的返回地址。在如果能够正确实现此函数,可在 lab1 中执行 make qemu后,在 qemu 模拟器中得到类似如下的输出:

……

ebp:0x00007b28 eip:0x00100992 args:0x00010094 0x00010094 0x00007b58 0x00100096

kern/debug/kdebug.c:305: print_stackframe+22

ebp:0x00007b38 eip:0x00100c79 args:0x00000000 0x00000000 0x00000000 0x00007ba8

kern/debug/kmonitor.c:125: mon_backtrace+10

ebp:0x00007b58 eip:0x00100096 args:0x00000000 0x00007b80 0xffff0000 0x00007b84

kern/init/init.c:48: grade_backtrace2+33

ebp:0x00007b78 eip:0x001000bf args:0x00000000 0xffff0000 0x00007ba4 0x00000029

kern/init/init.c:53: grade_backtrace1+38

ebp:0x00007b98 eip:0x001000dd args:0x00000000 0x00100000 0xffff0000 0x0000001d

kern/init/init.c:58: grade_backtrace0+23

ebp:0x00007bb8 eip:0x00100102 args:0x0010353c 0x00103520 0x00001308 0x00000000

kern/init/init.c:63: grade_backtrace+34

ebp:0x00007be8 eip:0x00100059 args:0x00000000 0x00000000 0x00000000 0x00007c53

kern/init/init.c:28: kern_init+88

ebp:0x00007bf8 eip:0x00007d73 args:0xc031fcfa 0xc08ed88e 0x64e4d08e 0xfa7502a8

<unknow>: -- 0x00007d72 –

……本练习任务:

请完成实验,看看输出是否与上述显示大致一致,并解释最后一行各个数值的含义。

要求完成函数kern/debug/kdebug.c::print_stackframe的实现,提交改进后源代码包(可以编译执行),并在实验报告中简要说明实现过程,并写出对上述问题的回答。

提示:可阅读小节函数堆栈,了解编译器是如何建立函数调用关系的。在完成 lab1 编译后,查看lab1/obj/bootblock.asm,了解 bootloader 源码与机器码的语句和地址等的对应关系;查看lab1/obj/kernel.asm,了解 ucore OS 源码与机器码的语句和地址等的对应关系。

补充材料:

由于显示完整的栈结构需要解析内核文件中的调试符号,较为复杂和繁琐。代码中有一些辅助函数可以使用。例如可以通过调用 print_debuginfo 函数完成查找对应函数名并打印至屏幕的功能。具体可以参见 kdebug.c 代码中的注释。

问题解答

实现后的print_stackframe代码如下(已加注释):

/*

| 栈底方向 | 高位地址

| ... |

| ... |

| 参数3 |

| 参数2 |

| 参数1 |

| 返回地址 |

| 上一层[ebp] | <-------- [ebp]

| 局部变量 | 低位地址

*/

void print_stackframe(void)

{

/* LAB1 YOUR CODE : STEP 1 */

/* (1) call read_ebp() to get the value of ebp. the type is (uint32_t);

* (2) call read_eip() to get the value of eip. the type is (uint32_t);

* (3) from 0 .. STACKFRAME_DEPTH

* (3.1) printf value of ebp, eip

* (3.2) (uint32_t)calling arguments [0..4] = the contents in address (uint32_t)ebp +2 [0..4]

* (3.3) cprintf("\n");

* (3.4) call print_debuginfo(eip-1) to print the C calling function name and line number, etc.

* (3.5) popup a calling stackframe

* NOTICE: the calling funciton's return addr eip = ss:[ebp+4]

* the calling funciton's ebp = ss:[ebp]

*/

//读入ebp,eip

uint32_t ebp = read_ebp(), eip = read_eip();

uint32_t *arguments;

int i, j;

//如果ebp非零并且没有达到规定的STACKFRAME_DEPTH的上限,则继续循环打印栈上栈帧和对应函数的信息

for (i = 0; ebp != 0 && i < STACKFRAME_DEPTH; i++)

{

cprintf("ebp: 0x%08x eip:0x%08x args:", ebp, eip);

arguments = (uint32_t *)ebp + 2;

for (j = 0; j < 4; j++)

{

cprintf("0x%08x ", arguments[j]);

}

cprintf("\n");

// eip指向的是即将执行的指令,所以如果想要查看当前函数,需要减1。

print_debuginfo(eip-1);

// 将ebp和eip设置为上一个栈帧的ebp和eip

// 注意要先设置eip后设置ebp,否则当ebp被修改后,eip就无法找到正确的ebp

eip = *((uint32_t *)ebp + 1);

ebp = *(uint32_t *)ebp;

}

}

代码分析:先用read_ebp与read_eip获得最初的ebp与eip寄存器的值,根据注释中的要求与输出结果规范,将ebp和eip输出。参数的值在ebp+2这个地址,我们用变量arguments将其保存,并通过arguments[0..3]输出参数的值,用print_debuginfo输出当前函数信息,最后用ebp指针更新下一次循环时ebp与eip的值。

需要注意的是:

- 栈的方向是从高地址向低地址增长的

- 指针运算要小心,避免因为错误的运算顺序(例如先相加,再强制转换为指针类型)而导致指针的运算错误

- 在切换栈帧时,先切换

eip,后切换ebp,两者顺序不能颠倒 - 如果想与标准答案对比自己输出的信息是否正确,在

labcodes_answer/lab1_result下运行make qemu即可

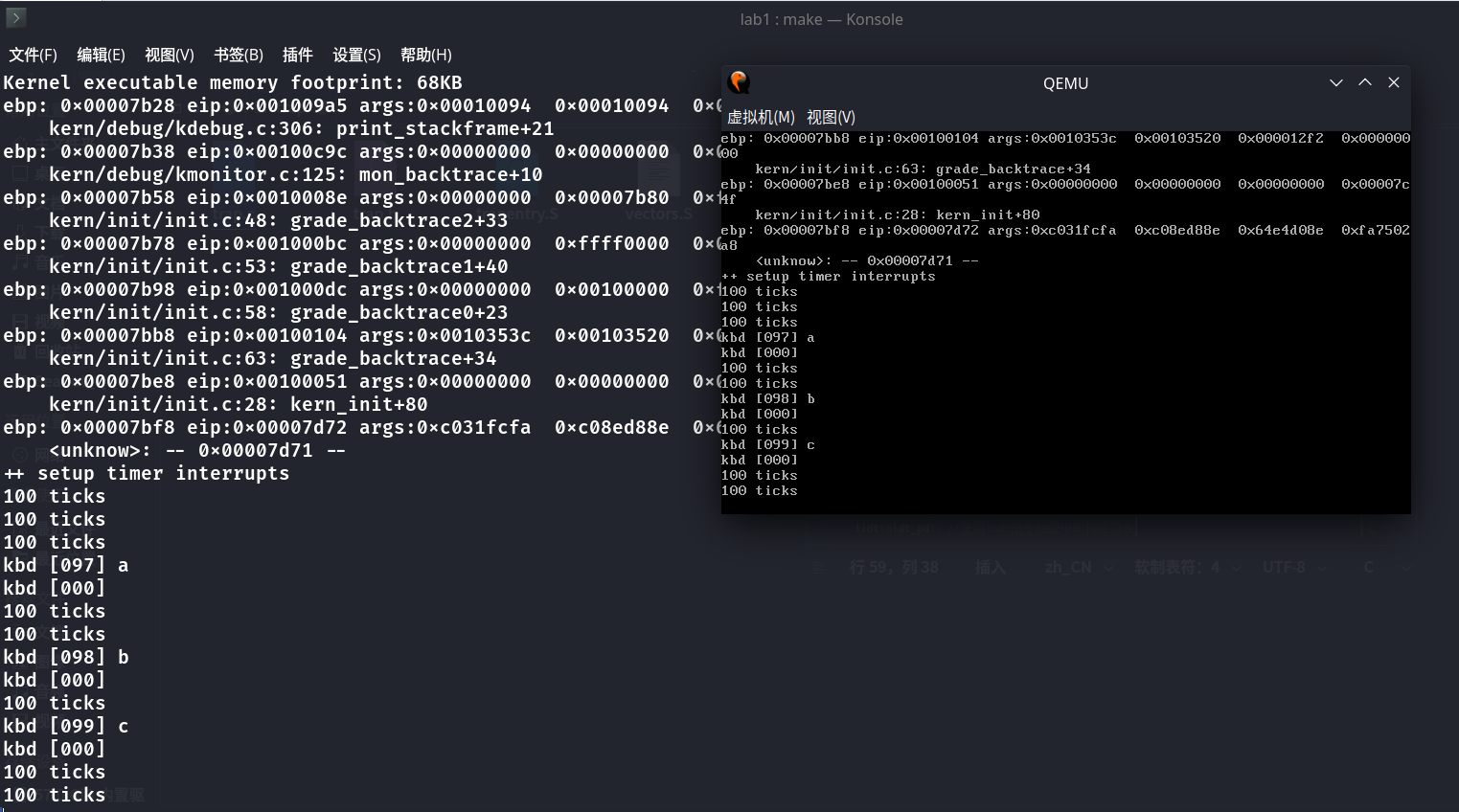

代码保存后在labcodes/lab1目录下执行make qemu,应该得到如下结果:

+ cc kern/debug/kdebug.c

+ ld bin/kernel

记录了10000+0 的读入

记录了10000+0 的写出

5120000字节(5.1 MB,4.9 MiB)已复制,0.0255234 s,201 MB/s

记录了1+0 的读入

记录了1+0 的写出

512字节已复制,0.000180683 s,2.8 MB/s

记录了153+1 的读入

记录了153+1 的写出

78784字节(79 kB,77 KiB)已复制,0.000332568 s,237 MB/s

WARNING: Image format was not specified for 'bin/ucore.img' and probing guessed raw.

Automatically detecting the format is dangerous for raw images, write operations on block 0 will be restricted.

Specify the 'raw' format explicitly to remove the restrictions.

(THU.CST) os is loading ...

Special kernel symbols:

entry 0x00100000 (phys)

etext 0x0010334f (phys)

edata 0x0010fa16 (phys)

end 0x00110d08 (phys)

Kernel executable memory footprint: 68KB

ebp: 0x00007b28 eip:0x001009a5 args:0x00010094 0x00010094 0x00007b58 0x0010008e

kern/debug/kdebug.c:306: print_stackframe+21

ebp: 0x00007b38 eip:0x00100c9c args:0x00000000 0x00000000 0x00000000 0x00007ba8

kern/debug/kmonitor.c:125: mon_backtrace+10

ebp: 0x00007b58 eip:0x0010008e args:0x00000000 0x00007b80 0xffff0000 0x00007b84

kern/init/init.c:48: grade_backtrace2+33

ebp: 0x00007b78 eip:0x001000bc args:0x00000000 0xffff0000 0x00007ba4 0x00000029

kern/init/init.c:53: grade_backtrace1+40

ebp: 0x00007b98 eip:0x001000dc args:0x00000000 0x00100000 0xffff0000 0x0000001d

kern/init/init.c:58: grade_backtrace0+23

ebp: 0x00007bb8 eip:0x00100104 args:0x0010337c 0x00103360 0x000012f2 0x00000000

kern/init/init.c:63: grade_backtrace+34

ebp: 0x00007be8 eip:0x00100051 args:0x00000000 0x00000000 0x00000000 0x00007c4f

kern/init/init.c:28: kern_init+80

ebp: 0x00007bf8 eip:0x00007d72 args:0xc031fcfa 0xc08ed88e 0x64e4d08e 0xfa7502a8

<unknow>: -- 0x00007d71 --

++ setup timer interrupts最后一行的含义是:最初使用堆栈的那一个函数,即bootmain。 bootloader 设置的堆栈从0x7c00开始,使用call bootmain进入bootmain函数。 call 指令压栈,所以bootmain中ebp为0x7bf8。后面的unknow之后的0x00007d71是bootmain函数内调用 OS kernel 入口函数的指令的地址。eip则为0x00007d71的下一条地址,即0x00007d72。后面的args则表示传递给bootmain函数的参数,但是由于bootmain函数不需要任何参数,因此这些打印出来的数值并没有实际意义。

练习 6:完善中断初始化和处理 (需要编程)

本练习任务是 完成编码工作和回答如下问题:

中断描述符表(也可简称为保护模式下的中断向量表)中一个表项占多少字节?其中哪几位代表中断处理代码的入口?- 请编程完善

kern/trap/trap.c中对中断向量表进行初始化的函数idt_init。在idt_init函数中,依次对所有中断入口进行初始化。使用mmu.h中的SETGATE宏,填充 idt 数组内容。每个中断的入口由tools/vectors.c生成,使用trap.c中声明的vectors数组即可。 - 请编程完善

trap.c中的中断处理函数trap,在对时钟中断进行处理的部分填写 trap 函数中处理时钟中断的部分,使操作系统每遇到100次时钟中断后,调用print_ticks子程序,向屏幕上打印一行文字:100 ticks。

要求完成问题 2 和问题 3 提出的相关函数实现,提交改进后的源代码包(可以编译执行),并在实验报告中简要说明实现过程,并写出对问题 1 的回答。完成这问题 2 和 3 要求的部分代码后,运行整个系统,可以看到大约每1秒会输出一次 100 ticks,而按下的键也会在屏幕上显示。

提示:可阅读小节中断与异常了解。

注意:除了系统调用中断(T_SYSCALL)使用陷阱门描述符且权限为用户态权限以外,其它中断均使用特权级(DPL)为0的中断门描述符,权限为内核态权限;而 ucore 的应用程序处于特权级3,需要采用int 0x80指令操作(这种方式称为软中断,软件中断,Tra 中断,在 lab5 会碰到)来发出系统调用请求,并要能实现从特权级3到特权级0的转换,所以系统调用中断(T_SYSCALL)所对应的中断门描述符中的特权级(DPL)需要设置为3。

问题一解答

题目:中断描述符表(也可简称为保护模式下的中断向量表)中一个表项占多少字节?其中哪几位代表中断处理代码的入口?

在kern/mm/mmu.h中可以找到表项的结构代码如下:

/* Gate descriptors for interrupts and traps */

struct gatedesc {

unsigned gd_off_15_0 : 16; // low 16 bits of offset in segment

unsigned gd_ss : 16; // segment selector

unsigned gd_args : 5; // # args, 0 for interrupt/trap gates

unsigned gd_rsv1 : 3; // reserved(should be zero I guess)

unsigned gd_type : 4; // type(STS_{TG,IG32,TG32})

unsigned gd_s : 1; // must be 0 (system)

unsigned gd_dpl : 2; // descriptor(meaning new) privilege level

unsigned gd_p : 1; // Present

unsigned gd_off_31_16 : 16; // high bits of offset in segment

};

中断向量表一个表项的大小为16+16+5+3+4+1+2+1+16=8*8=64bit,即8 字节。其中0-15 位和48-63 位分别为偏移量的低 16 位和高 16 位,两者拼接得到段内偏移量,16-31 位gd_ss为段选择器。根据段选择子和段内偏移地址就可以得出中断处理程序的地址。

问题二解答

题目:请编程完善 kern/trap/trap.c 中对中断向量表进行初始化的函数 idt_init。在 idt_init 函数中,依次对所有中断入口进行初始化。使用 mmu.h 中的 SETGATE 宏,填充 idt 数组内容。每个中断的入口由 tools/vectors.c 生成,使用 trap.c 中声明的 vectors 数组即可。

实现后的idt_init代码如下(已加注释):

/* idt_init - initialize IDT to each of the entry points in kern/trap/vectors.S */

void idt_init(void)

{

/* LAB1 YOUR CODE : STEP 2 */

/* (1) Where are the entry addrs of each Interrupt Service Routine (ISR)?

* All ISR's entry addrs are stored in __vectors. where is uintptr_t __vectors[] ?

* __vectors[] is in kern/trap/vector.S which is produced by tools/vector.c

* (try "make" command in lab1, then you will find vector.S in kern/trap DIR)

* You can use "extern uintptr_t __vectors[];" to define this extern variable which will be used later.

* (2) Now you should setup the entries of ISR in Interrupt Description Table (IDT).

* Can you see idt[256] in this file? Yes, it's IDT! you can use SETGATE macro to setup each item of IDT

* (3) After setup the contents of IDT, you will let CPU know where is the IDT by using 'lidt' instruction.

* You don't know the meaning of this instruction? just google it! and check the libs/x86.h to know more.

* Notice: the argument of lidt is idt_pd. try to find it!

*/

extern uintptr_t __vectors[]; //声明中断入口,__vectors定义于vector.S中

uint32_t i;

for (i = 0; i < (sizeof(idt) / sizeof(struct gatedesc)); i++)

{

// 该idt项为内核代码,所以使用GD_KTEXT段选择子

// 中断处理程序的入口地址存放于__vectors[i]

// 特权级为DPL_KERNEL

SETGATE(idt[i], 0, GD_KTEXT, __vectors[i], DPL_KERNEL); //为中断程序设置内核态权限

}

SETGATE(idt[T_SYSCALL], 0, GD_KTEXT, __vectors[T_SYSCALL], DPL_USER); //为T_SYSCALL设置用户态权限

lidt(&idt_pd); //使用lidt指令加载中断描述符表

}

传入SETGATE的参数:

- 第一个参数 gate 是中断描述符表

- 第二个参数 istrap 用来判断是中断还是 trap

- 第三个参数 sel 的作用是进行段的选择

- 第四个参数 off 表示偏移

- 第五个参数 dpl 表示中断的优先级

代码分析:题目要求我们为每个中断设置权限,只有T_SYSCALL是用户态权限(DPL_USER),其他都为内核态权限(DPL_KERNEL)。首先通过__vectors[]获得所有中断的入口,再通过循环为每个中断设置权限(默认为内核态权限),为T_SYSCALL设置用户态权限,最后通过lidt将 IDT 的起始地址装入 IDTR 寄存器即可。

问题三解答

题目:请编程完善 trap.c 中的中断处理函数 trap,在对时钟中断进行处理的部分填写 trap 函数中处理时钟中断的部分,使操作系统每遇到 100 次时钟中断后,调用 print_ticks 子程序,向屏幕上打印一行文字:100 ticks。

由于所有中断最后都是统一在trap_dispatch中进行处理或者分配的,因此不妨考虑在该函数中对应处理时钟中断的部分,对全局变量ticks加 1,并且当计数到达100时,调用print_ticks函数,从而完成每隔一段时间打印100 ticks的功能。

实现后的trap_dispatch代码如下(本练习仅添加了下方的第 18-20 行):

/* trap_dispatch - dispatch based on what type of trap occurred */

static void

trap_dispatch(struct trapframe *tf)

{

char c;

switch (tf->tf_trapno)

{

case IRQ_OFFSET + IRQ_TIMER:

/* LAB1 YOUR CODE : STEP 3 */

/* handle the timer interrupt */

/* (1) After a timer interrupt, you should record this event using a global variable (increase it), such as ticks in kern/driver/clock.c

* (2) Every TICK_NUM cycle, you can print some info using a funciton, such as print_ticks().

* (3) Too Simple? Yes, I think so!

*/

// 全局变量ticks定义于kern/driver/clock.c

ticks++;

if (ticks % TICK_NUM == 0)//每次时钟中断之后ticks就会加1,当加到TICK_NUM次数时,打印ticks并重新开始

print_ticks();//打印ticks

break;

case IRQ_OFFSET + IRQ_COM1:

c = cons_getc();

cprintf("serial [%03d] %c\n", c, c);

break;

case IRQ_OFFSET + IRQ_KBD:

c = cons_getc();

cprintf("kbd [%03d] %c\n", c, c);

break;

//LAB1 CHALLENGE 1 : YOUR CODE you should modify below codes.

case T_SWITCH_TOU:

case T_SWITCH_TOK:

panic("T_SWITCH_** ??\n");

break;

case IRQ_OFFSET + IRQ_IDE1:

case IRQ_OFFSET + IRQ_IDE2:

/* do nothing */

break;

default:

// in kernel, it must be a mistake

if ((tf->tf_cs & 3) == 0)

{

print_trapframe(tf);

panic("unexpected trap in kernel.\n");

}

}

}

代码保存后在labcodes/lab1下运行make qemu应该大致得到如下结果:

扩展练习 Challenge 1(需要编程)

本练习任务:

扩展proj4,增加syscall功能,即增加一用户态函数(可执行一特定系统调用:获得时钟计数值),当内核初始完毕后,可从内核态返回到用户态的函数,而用户态的函数又通过系统调用得到内核态的服务(通过网络查询所需信息,可找老师咨询。如果完成,且有兴趣做代替考试的实验,可找老师商量)。需写出详细的设计和分析报告。完成出色的可获得适当加分。

提示: 规范一下challenge的流程。

kern_init 调用 switch_test,该函数如下:

static void

switch_test(void) {

print_cur_status(); // print 当前 cs/ss/ds 等寄存器状态

cprintf("+++ switch to user mode +++\n");

switch_to_user(); // switch to user mode

print_cur_status();

cprintf("+++ switch to kernel mode +++\n");

switch_to_kernel(); // switch to kernel mode

print_cur_status();

}switch_to 函数建议通过中断处理的方式实现。主要要完成的代码是在 trap 里面处理 T_SWITCH_TO 中断,并设置好返回的状态。

在 lab1 里面完成代码以后,执行make grade应该能够评测结果是否正确。

开摆。

扩展练习 Challenge 2(需要编程)

本练习任务:

用键盘实现用户模式内核模式切换。具体目标是:键盘输入3时切换到用户模式,键盘输入0时切换到内核模式。 基本思路是借鉴软中断(syscall 功能)的代码,并且把 trap.c 中软中断处理的设置语句拿过来。

注意:

1.关于调试工具,不建议用 lab1_print_cur_status()来显示,要注意到寄存器的值要在中断完成后 tranentry.S 里面 iret 结束的时候才写回,所以再 trap.c 里面不好观察,建议用 print_trapframe(tf)

2.关于内联汇编,最开始调试的时候,参数容易出现错误,可能的错误代码如下:

asm volatile ( "sub $0x8, %%esp \n"

"int %0 \n"

"movl %%ebp, %%esp"

: )要去掉参数int %0 \n这一行。

3.软中断是利用了临时栈来处理的,所以有压栈和出栈的汇编语句。硬件中断本身就在内核态了,直接处理就可以了。

开摆。

实验内容(理论部分) - 从机器启动到操作系统运行的过程

BIOS 启动过程

当计算机加电后,一般不直接执行操作系统,而是执行系统初始化软件完成基本 IO 初始化和引导加载功能。简单地说,系统初始化软件就是在操作系统内核运行之前运行的一段小软件。通过这段小软件,我们可以初始化硬件设备、建立系统的内存空间映射图,从而将系统的软硬件环境带到一个合适的状态,以便为最终调用操作系统内核准备好正确的环境。最终引导加载程序把操作系统内核映像加载到 RAM 中,并将系统控制权传递给它。

对于绝大多数计算机系统而言,操作系统和应用软件是存放在磁盘(硬盘/软盘)、光盘、EPROM、ROM、Flash 等可在掉电后继续保存数据的存储介质上。计算机启动后,CPU 一开始会到一个特定的地址开始执行指令,这个特定的地址存放了系统初始化软件,负责完成计算机基本的 IO 初始化,这是系统加电后运行的第一段软件代码。对于 Intel 80386 的体系结构而言,PC 机中的系统初始化软件由 BIOS (Basic Input Output System,即基本输入/输出系统,其本质是一个固化在主板 Flash/CMOS 上的软件)和位于软盘/硬盘引导扇区中的 OS Boot Loader(在 ucore 中的 bootasm.S 和 bootmain.c)一起组成。BIOS 实际上是被固化在计算机 ROM(只读存储器)芯片上的一个特殊的软件,为上层软件提供最底层的、最直接的硬件控制与支持。更形象地说,BIOS 就是 PC 计算机硬件与上层软件程序之间的一个"桥梁",负责访问和控制硬件。

以 Intel 80386 为例,计算机加电后,CPU 从物理地址 0xFFFFFFF0(由初始化的 CS:EIP 确定,此时 CS 和 IP 的值分别是 0xF000 和 0xFFF0)开始执行。在 0xFFFFFFF0 这里只是存放了一条跳转指令,通过跳转指令跳到 BIOS 例行程序起始点。BIOS 做完计算机硬件自检和初始化后,会选择一个启动设备(例如软盘、硬盘、光盘等),并且读取该设备的第一扇区(即主引导扇区或启动扇区)到内存一个特定的地址 0x7c00 处,然后 CPU 控制权会转移到那个地址继续执行。至此 BIOS 的初始化工作做完了,进一步的工作交给了 ucore 的 bootloader。

补充信息:

Intel 的 CPU 具有很好的向后兼容性。在 16 位的 8086 CPU 时代,内存限制在 1MB 范围内,且 BIOS 的代码固化在 EPROM 中。在基于 Intel 的 8086 CPU 的 PC 机中的 EPROM 被编址在 1 M B 内存地址空间的最高 64KB 中。PC 加电后,CS 寄存器初始化为 0xF000,IP 寄存器初始化为 0xFFF0,所以 CPU 要执行的第一条指令的地址为 CS:IP=0xF000:0XFFF0(Segment:Offset 表示)=0xFFFF0(Linear 表示)。这个地址位于被固化 EPROM 中,指令是一个长跳转指令 JMP F000:E05B 。这样就开启了 BIOS 的执行过程。

到了 32 位的 80386 CPU 时代,内存空间扩大到了 4G,多了段机制和页机制,但 Intel 依然很好地保证了 80386 向后兼容 8086。地址空间的变化导致无法直接采用 8086 的启动约定。如果把 BIOS 启动固件编址在 0xF000 起始的 64KB 内存地址空间内,就会把整个物理内存地址空间隔离成不连续的两段,一段是 0xF000 以前的地址,一段是 1MB 以后的地址,这很不协调。为此,intel 采用了一个折中的方案:默认将执行 BIOS ROM 编址在 32 位内存地址空间的最高端,即位于 4GB 地址的最后一个 64KB 内。在 PC 系统开机复位时,CPU 进入实模式,并将 CS 寄存器设置成 0xF000,将它的 shadow register 的 Base 值初始化设置为 0xFFFF0000,EIP 寄存器初始化设置为 0x0000FFF0。所以机器执行的第一条指令的物理地址是 0xFFFFFFF0。80386 的 BIOS 代码也要和以前 8086 的 BIOS 代码兼容,故地址 0xFFFFFFF0 处的指令还是一条长跳转指令 jmp F000:E05B 。注意,这个长跳转指令会触发更新 CS 寄存器和它的 shadow register,即执行 jmp F000 : E05B 后,CS 将被更新成 0xF000。表面上看 CS 其实没有变化,但 CS 的 shadow register 被更新为另外一个值了,它的 Base 域被更新成 0x000F0000,此时形成的物理地址为 Base+EIP=0x000FE05B,这就是 CPU 执行的第二条指令的地址。此时这条指令的地址已经是 1M 以内了,且此地址不再位于 BIOS ROM 中,而是位于 RAM 空间中。由于 Intel 设计了一种映射机制,将内存高端的 BIOS ROM 映射到 1MB 以内的 RAM 空间里,并且可以使这一段被映射的 RAM 空间具有与 ROM 类似的只读属性。所以 PC 机启动时将开启这种映射机制,让 4GB 地址空间的最高一个 64KB 的内容等同于 1MB 地址空间的最高一个 64K 的内容,从而使得执行了长跳转指令后,其实是回到了早期的 8086 CPU 初始化控制流,保证了向下兼容。

bootloader 启动过程

BIOS 将通过读取硬盘主引导扇区到内存,并转跳到对应内存中的位置执行 bootloader。bootloader 完成的工作包括:

- 切换到保护模式,启用分段机制

- 读磁盘中 ELF 执行文件格式的 ucore 操作系统到内存

- 显示字符串信息

- 把控制权交给 ucore 操作系统

对应其工作的实现文件在 lab1 中的 boot 目录下的三个文件 asm.h、bootasm.S 和 bootmain.c。下面从原理上介绍完成上述工作的计算机系统硬件和软件背景知识。

保护模式和分段机制

此处内容过多,点击打开实验指导书查看。

地址空间

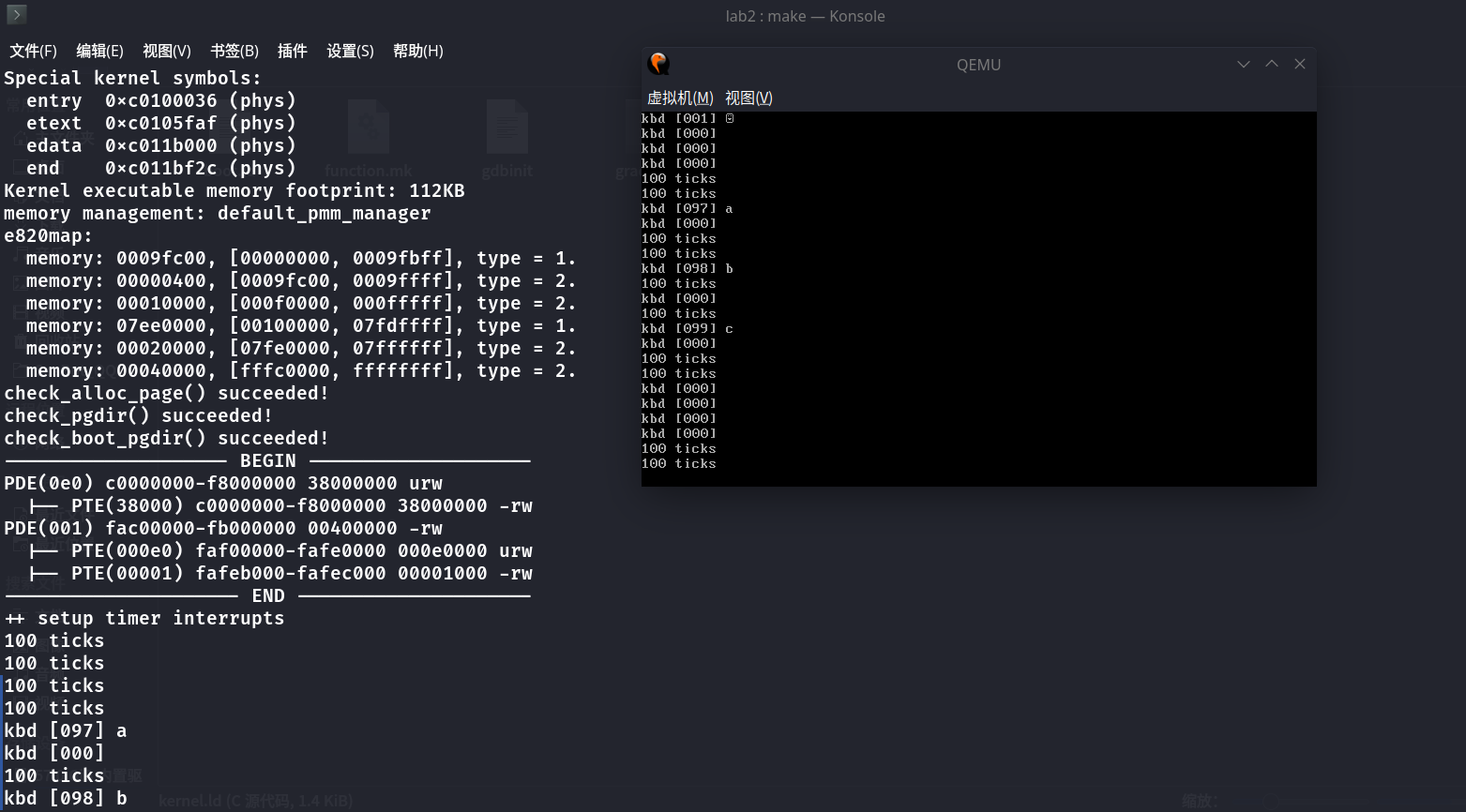

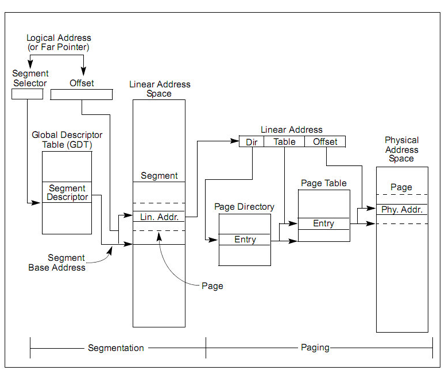

分段机制涉及 5 个关键内容:逻辑地址(Logical Address,应用程序员看到的地址,在操作系统原理上称为虚拟地址,以后提到虚拟地址就是指逻辑地址)、物理地址(Physical Address, 实际的物理内存地址)、段描述符表(包含多个段描述符的“数组”)、段描述符(描述段的属性,及段描述符表这个“数组”中的“数组元素”)、段选择子(即段寄存器中的值,用于定位段描述符表中段描述符表项的索引)

(1) 逻辑地址空间 从应用程序的角度看,逻辑地址空间就是应用程序员编程所用到的地址空间,比如下面的程序片段: int val=100; int * point=&val;

其中指针变量 point 中存储的即是一个逻辑地址。在基于 80386 的计算机系统中,逻辑地址有一个 16 位的段寄存器(也称段选择子,段选择子)和一个 32 位的偏移量构成。

(2) 物理地址空间 从操作系统的角度看,CPU、内存硬件(通常说的“内存条”)和各种外设是它主要管理的硬件资源而内存硬件和外设分布在物理地址空间中。物理地址空间就是一个“大数组”,CPU 通过索引(物理地址)来访问这个“大数组”中的内容。物理地址是指 CPU 提交到内存总线上用于访问计算机内存和外设的最终地址。

物理地址空间的大小取决于 CPU 实现的物理地址位数,在基于 80386 的计算机系统中,CPU 的物理地址空间为 4GB,如果计算机系统实际上有 1GB 物理内存(即我们通常说的内存条),而其他硬件设备的 IO 寄存器映射到起始物理地址为 3GB 的 256MB 大小的地址空间,则该计算机系统的物理地址空间如下所示:

+------------------+ <- 0xFFFFFFFF (4GB)

| 无效空间 |

| |

+------------------+ <- addr:3G+256M

| 256MB |

| IO外设地址空间 |

| |

+------------------+ <- 0xC0000000(3GB)

| |

/\/\/\/\/\/\/\/\/\/\

/\/\/\/\/\/\/\/\/\/\

| 无效空间 |

+------------------+ <- 0x40000000(1GB)

| |

| 实际有效内存 |

| |

+------------------+ <- 0x00100000 (1MB)

| BIOS ROM |

+------------------+ <- 0x000F0000 (960KB)

| 16-bit devices, |

| expansion ROMs |

+------------------+ <- 0x000C0000 (768KB)

| VGA Display |

+------------------+ <- 0x000A0000 (640KB)

| |

| Low Memory |

| |

+------------------+ <- 0x00000000(3) 线性地址空间 一台计算机只有一个物理地址空间,但在操作系统的管理下,每个程序都认为自己独占整个计算机的物理地址空间。为了让多个程序能够有效地相互隔离和使用物理地址空间,引入线性地址空间(也称虚拟地址空间)的概念。线性地址空间的大小取决于 CPU 实现的线性地址位数,在基于 80386 的计算机系统中,CPU 的线性地址空间为 4GB。线性地址空间会被映射到某一部分或整个物理地址空间,并通过索引(线性地址)来访问其中的内容。线性地址又称虚拟地址,是进行逻辑地址转换后形成的地址索引,用于寻址线性地址空间。但 CPU 未启动分页机制时,线性地址等于物理地址;当 CPU 启动分页机制时,线性地址还需经过分页地址转换形成物理地址后,CPU 才能访问内存硬件和外设。三种地址的关系如下所示:

- 启动分段机制,未启动分页机制:逻辑地址--> (分段地址转换) -->线性地址==物理地址

- 启动分段和分页机制:逻辑地址--> (分段地址转换) -->线性地址-->(分页地址转换) -->物理地址

在操作系统的管理下,采用灵活的内存管理机制,在只有一个物理地址空间的情况下,可以存在多个线性地址空间。

硬盘访问概述

bootloader 让 CPU 进入保护模式后,下一步的工作就是从硬盘上加载并运行 OS。考虑到实现的简单性,bootloader 的访问硬盘都是 LBA 模式的 PIO(Program IO)方式,即所有的 IO 操作是通过 CPU 访问硬盘的 IO 地址寄存器完成。

一般主板有 2 个 IDE 通道,每个通道可以接 2 个 IDE 硬盘。访问第一个硬盘的扇区可设置 IO 地址寄存器 0x1f0-0x1f7 实现的,具体参数见下表。一般第一个 IDE 通道通过访问 IO 地址 0x1f0-0x1f7 来实现,第二个 IDE 通道通过访问 0x170-0x17f 实现。每个通道的主从盘的选择通过第 6 个 IO 偏移地址寄存器来设置。

表格:磁盘 IO 地址和对应功能

第 6 位:为 1=LBA 模式;0 = CHS 模式 第 7 位和第 5 位必须为 1

| IO 地址 | 功能 |

|---|---|

| 0x1f0 | 读数据,当 0x1f7 不为忙状态时,可以读。 |

| 0x1f2 | 要读写的扇区数,每次读写前,你需要表明你要读写几个扇区。最小是 1 个扇区 |

| 0x1f3 | 如果是 LBA 模式,就是 LBA 参数的 0-7 位 |

| 0x1f4 | 如果是 LBA 模式,就是 LBA 参数的 8-15 位 |

| 0x1f5 | 如果是 LBA 模式,就是 LBA 参数的 16-23 位 |

| 0x1f6 | 第 0~3 位:如果是 LBA 模式就是 24-27 位 第 4 位:为 0 主盘;为 1 从盘 |

| 0x1f7 | 状态和命令寄存器。操作时先给命令,再读取,如果不是忙状态就从 0x1f0 端口读数据 |

当前硬盘数据是储存到硬盘扇区中,一个扇区大小为 512 字节。读一个扇区的流程(可参看 boot/bootmain.c 中的 readsect 函数实现)大致如下:

- 等待磁盘准备好

- 发出读取扇区的命令

- 等待磁盘准备好

- 把磁盘扇区数据读到指定内存

ELF 文件格式概述

ELF(Executable and linking format)文件格式是 Linux 系统下的一种常用目标文件(object file)格式,有三种主要类型:

- 用于执行的可执行文件(executable file),用于提供程序的进程映像,加载的内存执行。 这也是本实验的 OS 文件类型。

- 用于连接的可重定位文件(relocatable file),可与其它目标文件一起创建可执行文件和共享目标文件。

- 共享目标文件(shared object file),连接器可将它与其它可重定位文件和共享目标文件连接成其它的目标文件,动态连接器又可将它与可执行文件和其它共享目标文件结合起来创建一个进程映像。

这里只分析与本实验相关的 ELF 可执行文件类型。ELF header 在文件开始处描述了整个文件的组织。ELF 的文件头包含整个执行文件的控制结构,其定义在 elf.h 中:

struct elfhdr {

uint magic; // must equal ELF_MAGIC

uchar elf[12];

ushort type;

ushort machine;

uint version;

uint entry; // 程序入口的虚拟地址

uint phoff; // program header 表的位置偏移

uint shoff;

uint flags;

ushort ehsize;

ushort phentsize;

ushort phnum; //program header表中的入口数目

ushort shentsize;

ushort shnum;

ushort shstrndx;

};program header 描述与程序执行直接相关的目标文件结构信息,用来在文件中定位各个段的映像,同时包含其他一些用来为程序创建进程映像所必需的信息。可执行文件的程序头部是一个 program header 结构的数组, 每个结构描述了一个段或者系统准备程序执行所必需的其它信息。目标文件的 “段” 包含一个或者多个 “节区”(section) ,也就是“段内容(Segment Contents)” 。程序头部仅对于可执行文件和共享目标文件有意义。可执行目标文件在 ELF 头部的 e_phentsize 和 e_phnum 成员中给出其自身程序头部的大小。程序头部的数据结构如下表所示:

struct proghdr {

uint type; // 段类型

uint offset; // 段相对文件头的偏移值

uint va; // 段的第一个字节将被放到内存中的虚拟地址

uint pa;

uint filesz;

uint memsz; // 段在内存映像中占用的字节数

uint flags;

uint align;

};根据 elfhdr 和 proghdr 的结构描述,bootloader 就可以完成对 ELF 格式的 ucore 操作系统的加载过程(参见 boot/bootmain.c 中的 bootmain 函数)。

补充材料

Link addr & Load addr

Link Address 是指编译器指定代码和数据所需要放置的内存地址,由链接器配置。Load Address 是指程序被实际加载到内存的位置(由程序加载器 ld 配置)。一般由可执行文件结构信息和加载器可保证这两个地址相同。Link Addr 和 LoadAddr 不同会导致:

- 直接跳转位置错误

- 直接内存访问(只读数据区或 bss 等直接地址访问)错误

- 堆和栈等的使用不受影响,但是可能会覆盖程序、数据区域 注意:也存在 Link 地址和 Load 地址不一样的情况(例如:动态链接库)。

操作系统启动过程

当 bootloader 通过读取硬盘扇区把 ucore 在系统加载到内存后,就转跳到 ucore 操作系统在内存中的入口位置(kern/init.c 中的 kern_init 函数的起始地址),这样 ucore 就接管了整个控制权。当前的 ucore 功能很简单,只完成基本的内存管理和外设中断管理。ucore 主要完成的工作包括:

- 初始化终端;

- 显示字符串;

- 显示堆栈中的多层函数调用关系;

- 切换到保护模式,启用分段机制;

- 初始化中断控制器,设置中断描述符表,初始化时钟中断,使能整个系统的中断机制;

- 执行 while(1)死循环。

以后的实验中会大量涉及各个函数直接的调用关系,以及由于中断处理导致的异步现象,可能对大家实现操作系统和改正其中的错误有很大影响。而理解好函数调用关系的建立机制和中断处理机制,对后续实验会有很大帮助。下面就练习 5 涉及的函数栈调用关系和练习 6 中的中断机制的建立进行阐述。

函数堆栈

栈是一个很重要的编程概念(编译课和程序设计课都讲过相关内容),与编译器和编程语言有紧密的联系。理解调用栈最重要的两点是:栈的结构,EBP 寄存器的作用。一个函数调用动作可分解为:零到多个 PUSH 指令(用于参数入栈),一个 CALL 指令。CALL 指令内部其实还暗含了一个将返回地址(即 CALL 指令下一条指令的地址)压栈的动作(由硬件完成)。几乎所有本地编译器都会在每个函数体之前插入类似如下的汇编指令:

pushl %ebp

movl %esp , %ebp这样在程序执行到一个函数的实际指令前,已经有以下数据顺序入栈:参数、返回地址、ebp 寄存器。由此得到类似如下的栈结构(参数入栈顺序跟调用方式有关,这里以 C 语言默认的 CDECL 为例):

+| 栈底方向 | 高位地址

| ... |

| ... |

| 参数3 |

| 参数2 |

| 参数1 |

| 返回地址 |

| 上一层[ebp] | <-------- [ebp]

| 局部变量 | 低位地址这两条汇编指令的含义是:首先将 ebp 寄存器入栈,然后将栈顶指针 esp 赋值给 ebp。“mov ebp esp”这条指令表面上看是用 esp 覆盖 ebp 原来的值,其实不然。因为给 ebp 赋值之前,原 ebp 值已经被压栈(位于栈顶),而新的 ebp 又恰恰指向栈顶。此时 ebp 寄存器就已经处于一个非常重要的地位,该寄存器中存储着栈中的一个地址(原 ebp 入栈后的栈顶),从该地址为基准,向上(栈底方向)能获取返回地址、参数值,向下(栈顶方向)能获取函数局部变量值,而该地址处又存储着上一层函数调用时的 ebp 值。

一般而言,ss:[ebp+4]处为返回地址,ss:[ebp+8]处为第一个参数值(最后一个入栈的参数值,此处假设其占用 4 字节内存),ss:[ebp-4]处为第一个局部变量,ss:[ebp]处为上一层 ebp 值。由于 ebp 中的地址处总是“上一层函数调用时的 ebp 值”,而在每一层函数调用中,都能通过当时的 ebp 值“向上(栈底方向)”能获取返回地址、参数值,“向下(栈顶方向)”能获取函数局部变量值。如此形成递归,直至到达栈底。这就是函数调用栈。

中断与异常

此处内容过多,点击打开实验指导书查看。

lab1 中对中断的处理实现

此处内容过多,点击打开实验指导书查看。

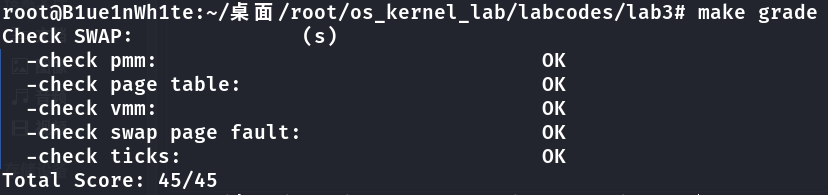

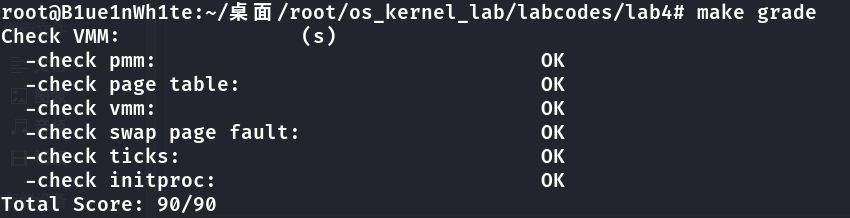

Lab 2 物理内存管理

实验目的

- 理解基于段页式内存地址的转换机制

- 理解页表的建立和使用方法

- 理解物理内存的管理方法

实验内容(操作部分)

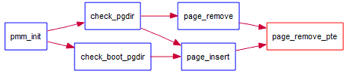

本次实验包含三个部分。首先了解如何发现系统中的物理内存;然后了解如何建立对物理内存的初步管理,即了解连续物理内存管理;最后了解页表相关的操作,即如何建立页表来实现虚拟内存到物理内存之间的映射,对段页式内存管理机制有一个比较全面的了解。本实验里面实现的内存管理还是非常基本的,并没有涉及到对实际机器的优化,比如针对 cache 的优化等。如果大家有余力,尝试完成扩展练习。在实验前请先阅读实验执行流程概述。

项目组成

Lab2 文件列表:

bash

|-- boot

| |-- asm.h

| |-- bootasm.S

| \`-- bootmain.c

|-- kern

| |-- init

| | |-- entry.S

| | \`-- init.c

| |-- mm

| | |-- default\_pmm.c

| | |-- default\_pmm.h

| | |-- memlayout.h

| | |-- mmu.h

| | |-- pmm.c

| | \`-- pmm.h

| |-- sync

| | \`-- sync.h

| \`-- trap

| |-- trap.c

| |-- trapentry.S

| |-- trap.h

| \`-- vectors.S

|-- libs

| |-- atomic.h

| |-- list.h

\`-- tools

|-- kernel.ld相对与实验一,实验二主要增加和修改的文件如上表所示。主要改动如下:

boot/bootasm.S:增加了对计算机系统中物理内存布局的探测功能kern/init/entry.S:根据临时段表重新暂时建立好新的段空间,为进行分页做好准备kern/mm/default_pmm.[ch]:提供基本的基于链表方法的物理内存管理(分配单位为页,即 4096 字节)kern/mm/pmm.[ch]:pmm.h 定义物理内存管理类框架 struct pmm_manager,基于此通用框架可以实现不同的物理内存管理策略和算法(default_pmm.[ch] 实现了一个基于此框架的简单物理内存管理策略); pmm.c 包含了对此物理内存管理类框架的访问,以及与建立、修改、访问页表相关的各种函数实现kern/sync/sync.h:为确保内存管理修改相关数据时不被中断打断,提供两个功能,一个是保存 eflag 寄存器中的中断屏蔽位信息并屏蔽中断的功能,另一个是根据保存的中断屏蔽位信息来使能中断的功能libs/list.h:定义了通用双向链表结构以及相关的查找、插入等基本操作,这是建立基于链表方法的物理内存管理(以及其他内核功能)的基础。其他有类似双向链表需求的内核功能模块可直接使用 list.h 中定义的函数libs/atomic.h:定义了对一个变量进行读写的原子操作,确保相关操作不被中断打断tools/kernel.ld:ld 形成执行文件的地址所用到的链接脚本。修改了 ucore 的起始入口和代码段的起始地址。相关细节可参看附录 C。

编译方法

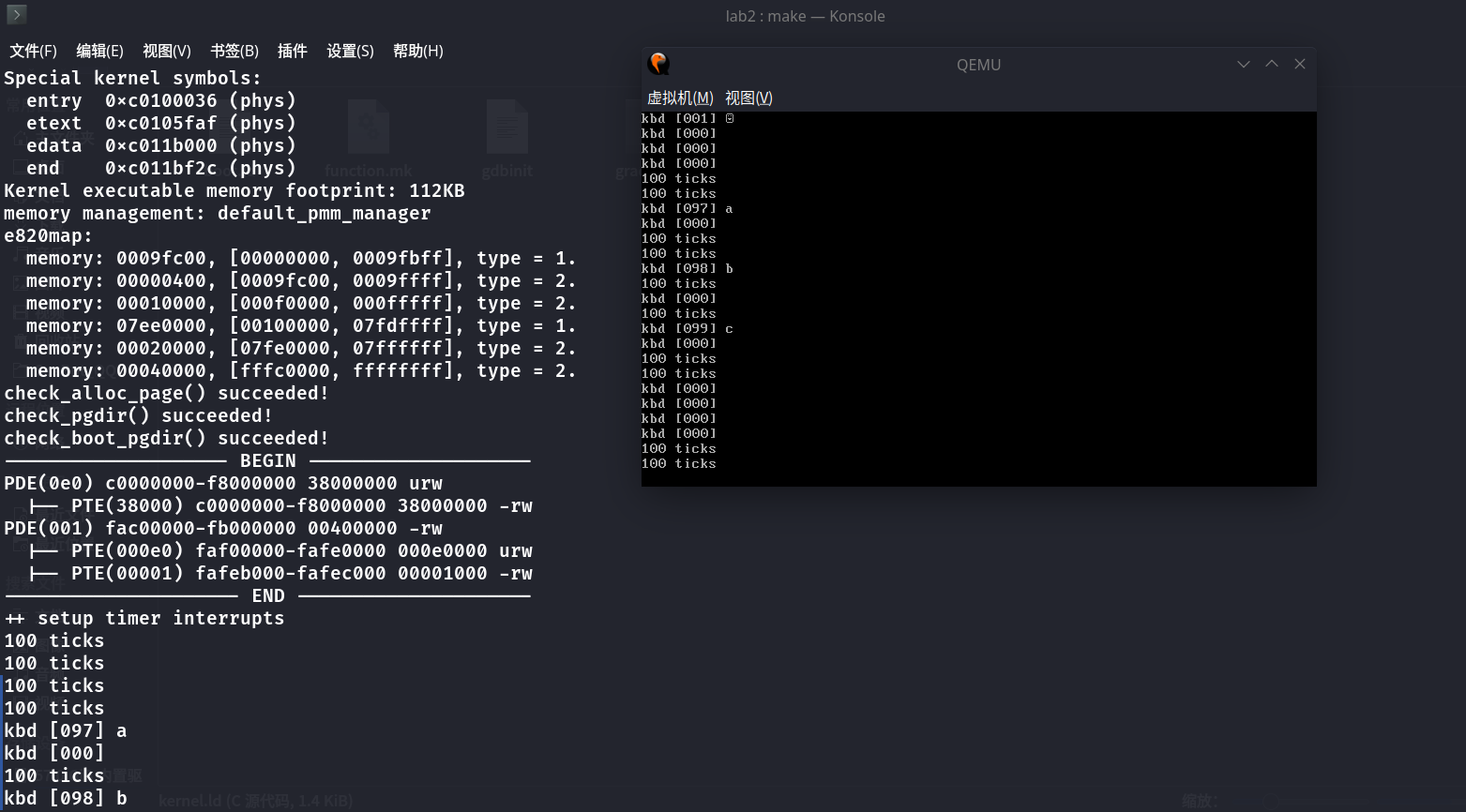

当完成实验后,在lab2目录下执行make qemu,可以得到如下显示界面(仅供参考):

chenyu$ make qemu

(THU.CST) os is loading ...

Special kernel symbols:

entry 0xc010002c (phys)

etext 0xc010537f (phys)

edata 0xc01169b8 (phys)

end 0xc01178dc (phys)

Kernel executable memory footprint: 95KB

memory managment: default_pmm_manager

e820map:

memory: 0009f400, [00000000, 0009f3ff], type = 1.

memory: 00000c00, [0009f400, 0009ffff], type = 2.

memory: 00010000, [000f0000, 000fffff], type = 2.

memory: 07efd000, [00100000, 07ffcfff], type = 1.

memory: 00003000, [07ffd000, 07ffffff], type = 2.

memory: 00040000, [fffc0000, ffffffff], type = 2.

check_alloc_page() succeeded!

check_pgdir() succeeded!

check_boot_pgdir() succeeded!

-------------------- BEGIN --------------------

PDE(0e0) c0000000-f8000000 38000000 urw

|-- PTE(38000) c0000000-f8000000 38000000 -rw

PDE(001) fac00000-fb000000 00400000 -rw

|-- PTE(000e0) faf00000-fafe0000 000e0000 urw

|-- PTE(00001) fafeb000-fafec000 00001000 -rw

--------------------- END ---------------------

++ setup timer interrupts

100 ticks

100 ticks